« La réalisation effective de l’ordinateur quantique laisse entrevoir une révolution de rupture qui touchera tous les domaines industriels »

Les capacités de calcul inédites que promet cette technologie encore en développement vont faire surgir des applications nouvelles, note Nozha Boujemaa dans sa carte blanche au « Monde », qui rappelle que la France dispose de scientifiques de grand talent dans ce domaine.

La situation

L’infiniment petit ne finit pas de nous surprendre et de nous émerveiller. Au tout début de ma carrière, je construisais à la main des lasers dits à « échos de photons » et c’était magique de voir jaillir une lumière cohérente puissante avec un minimum de maîtrise de physique quantique. L’analogie avec les « échos de spin » dans le domaine magnétique m’a amenée vers l’imagerie par résonance magnétique (IRM) et ses passionnantes applications en imagerie médicale.

Ces propriétés quantiques de la matière reviennent sur le devant de la scène des sciences et technologies du numérique. Cette dualité « onde-matière », ô combien intrigante tout au long de l’histoire des sciences, stipule qu’une particule est soumise à un principe de dualité qui défie les logiques de l’échelle macroscopique et échappe à l’intuition du monde réel : un objet peut être dans plusieurs états tant qu’on ne l’a pas mesuré (la superposition quantique) ; deux objets peuvent s’influencer à distance sans aucune communication (principe de non-localité ou d’intrication quantique).

L’ordinateur d’aujourd’hui fonctionne avec des bits (binary digits) à deux états, 0 et 1. L’informatique quantique fonctionne avec des qubits constitués par des superpositions d’états entre 0 et 1, où N qubits sont équivalents à 2N états. 70 bits quantiques superposés contiennent 270 informations (1 zettabit), ce qui équivaut à toute l’information produite par l’humanité. Cet effet exponentiel a un impact fort sur la quantité de données qui sera gérée en même temps.

A l’aube d’une nouvelle ère numérique

On ne maîtrise pas encore la réalisation technologique d’un ordinateur quantique. Le fait même d’observer un système quantique le perturbe et génère des erreurs nécessitant des conditions de stabilisation utilisant des températures de − 273 °C environ avec un matériel de refroidissement très encombrant. Nous ne sommes qu’à l’aube d’une nouvelle ère numérique qui a besoin de progrès technologiques gigantesques (comme pour les premiers transistors).

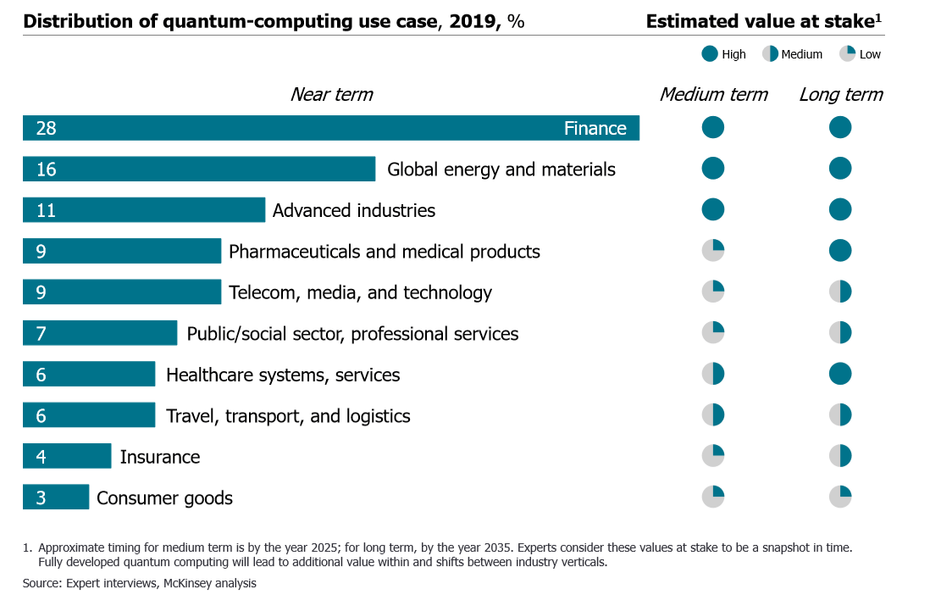

La réalisation effective de l’ordinateur quantique nous laisse cependant entrevoir une révolution de rupture qui touchera tous les domaines industriels. Ses capacités de traitement de l’information à large échelle pourront par exemple casser tous les codes secrets – on parle déjà de cryptologie post-quantique –, optimiser des parcours en logistique, simuler la mécanique des fluides ou l’écoulement de l’air sur l’aile d’un avion. Les transports bénéficieront évidemment de ces applications. L’informatique quantique s’attaquera à tout ce qui nécessite des calculs intensifs habituellement irréalisables dans des temps raisonnables par un ordinateur binaire limité dans l’exploration informationnelle.

Évidemment, l’intelligence artificielle, qui est l’art et la manière de traiter utilement une quantité importante de données, se verra boostée avec un saut vers des capacités dont on ignore aujourd’hui les limites et les implications dans la vie des humains. Cela a un côté extraordinaire, mais c’est aussi un saut vers l’inconnu, même si l’humanité n’en est pas à sa première aventure fantastique avec des technologies transformantes.

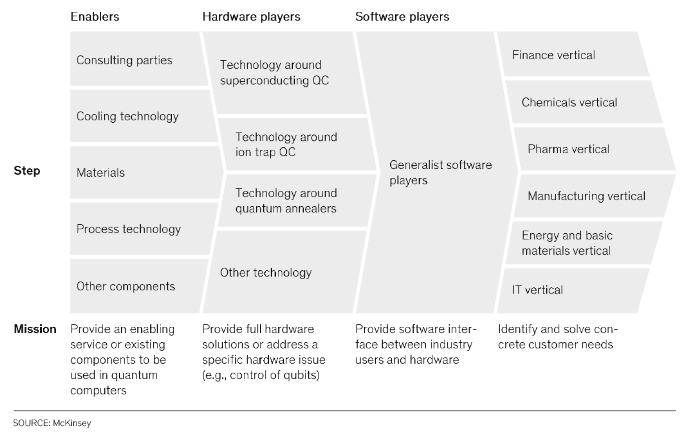

La course vers la suprématie quantique est active chez beaucoup d’acteurs publics et privés dans le monde entier comme Google, IBM, Atos, D-Wave et bien d’autres. Le président de la République a annoncé, début 2021, un plan d’investissement dans le quantique de 1,8 milliard d’euros sur cinq ans. La France dispose des meilleurs spécialistes en physique quantique, dont une bonne représentation sur le plateau de Saclay.

Le chemin vers la réalisation de l’ordinateur quantique sera long mais les technologies développées en cours de route seront elles aussi bénéfiques pour la compréhension de notre monde, avec un impact dans des domaines d’application inattendus.

Carte blanche à Nozha Boujemaa : La réalisation effective de l’ordinateur quantique laisse entrevoir une révolution de rupture qui touchera tous les domaines industriels

Publie sur Le Monde le 21 avril 2021