Source : documentation interne Microsolft

De la traduction automatique aux chatbots, en passant par les algorithmes auto-apprenants, l’intelligence artificielle (IA) recouvre l’ensemble des technologies capables de comprendre leur environnement et d’agir en conséquence. Aujourd’hui, grâce à l’IA, les machines peuvent accomplir des choses qui étaient encore inimaginables il y a quelques années : converser avec un humain en langage naturel, diagnostiquer des maladies… ou traduire des pages Wikipedia en quelques secondes. Une nouvelle ère s’annonce et les entreprises doivent prendre le train en marche. 5 chiffres-clés pour mieux cerner ce (vaste) sujet.

1950. L’année fondatrice de l’IA

C’est en 1950 qu’Alan Turing, mathématicien et cryptologue britannique, a publié Computing Machinery and Intelligence, introduisant le test de Turing. Le but de ce test (toujours utilisé aujourd’hui) : établir si un ordinateur se comporte, ou non, comme un être humain. Le test consiste à laisser une personne discuter à l’aveugle avec un autre humain et un ordinateur. La personne doit ensuite déterminer lequel de ses interlocuteurs est une machine.

Plusieurs décennies plus tard, les avancées sont colossales. Ainsi, en octobre 2016, des chercheurs Microsoft ont franchi une étape historique : pour la première fois, une IA s’est avérée aussi performante qu’un humain pour transcrire une conversation audio, une prouesse encore inimaginable cinq ans plus tôt.

Au-delà de l’exploit technologique, c’est un véritable changement de paradigme : pour Harry Shum, à la tête du Microsoft Artificial Intelligence and Research group, nous sommes en effet en train de passer d’un monde où les humains doivent comprendre les ordinateurs et parler leur langage à un monde où ce sont les machines qui doivent nous comprendre (et elles le font de mieux en mieux).

11,1 milliards de dollars : le marché potentiel de l’IA

C’est le montant que devrait atteindre le marché de l’IA d’ici 2024, contre 200 millions en 2015, d’après le cabinet d’analyse Tractica. La croissance exponentielle de la puissance des processus de traitement, combinée à une augmentation sans précédent des données disponibles, fait que l’IA est devenue extrêmement attractive pour les entreprises. Son déploiement entraîne des investissements importants en termes d’infrastructure, de formation, d’intégration et de maintenance, qui s’ajoutent à une hausse des budgets IT, notamment en ce qui concerne le hardware et le stockage (incluant le cloud).

Plus de 1 550 start-up consacrées à l’IA

Plus de 1 550 jeunes pousses consacrées à l’IA dans 70 pays, selon un rapport de Venture Scanner. Avec une levée de fonds moyenne de 22 millions de dollars par entreprise, on atteint le montant record de 10 milliards de dollars levés au total par les start-up de l’intelligence artificielle. Ce sont les applications de machine learning qui concentrent la majorité des investissements : autour de 3,5 millions de dollars pour 425 start-up.

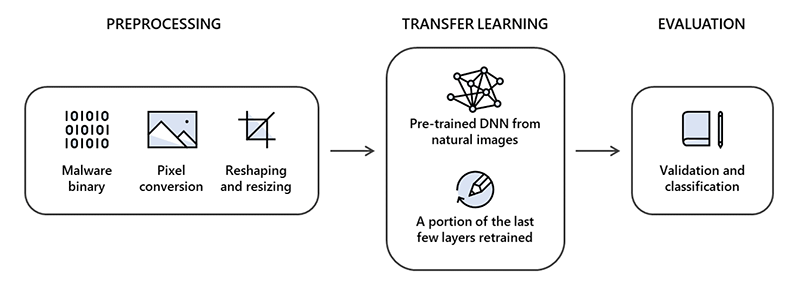

Certaines de ces start-up spécialisées choisissent de s’appuyer sur l’expertise et la force des grands groupes. En janvier 2017, Microsoft a ainsi annoncé l’acquisition de Maluuba, une pépite canadienne ayant une expertise poussée dans le deep learning et la compréhension du langage naturel. En novembre 2016, le groupe avait déjà établi un partenariat avec OpenAI, une start-up à but non lucratif fondée par Elon Musk, avec l’objectif de faire émerger une IA responsable et sécurisée.

60 langues traduites en temps réel

De l’anglais au maya yucatèque, en passant par le français ou le hmong daw, Microsoft Translator supporte aujourd’hui 60 langues. Et se décline pour les utilisateurs dans une application, un widget ou encore Translator for Bing. Des centaines d’entreprises, comme Amazon, LinkedIn, Etsy ou HP, utilisent déjà Microsoft Translator pour leurs contenus et applications, qu’ils soient destinés à l’interne ou à l’externe.

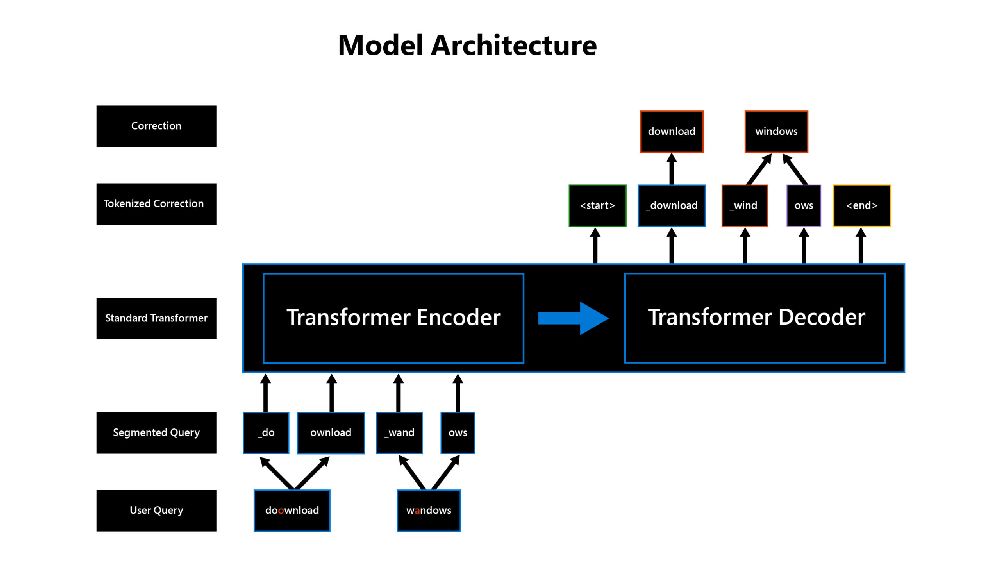

Une fonctionnalité inédite, introduite en décembre 2016, au Microsoft AI Event de San Francisco, permet désormais la traduction en temps réel, et donc de se passer d’un traducteur humain. Fondée sur des algorithmes qui fonctionnent à la manière d’un réseau neuronal, cette technologie est beaucoup plus fluide et proche du raisonnement humain que les systèmes de traduction automatique qui l’ont précédée. Et grâce au machine learning, elle est capable d’apprendre des corpus qui lui sont présentés.

+ 40 % de productivité grâce à l’IA

D’ici 2035, l’IA pourrait contribuer à augmenter la productivité mondiale de 40 %, d’après une étude Accenture de 2016.

« L’impact observé repose sur l’automatisation de tâches de faible niveau assurée par la technologie avec un meilleur rendu final » selon Paul Daugherty, le directeur technique d’Accenture qui a piloté l’étude. « Les salariés ont plus de temps pour accomplir d’autres tâches plus satisfaisantes, résoudre des problèmes et répondre aux questions complexes surgissant au fil de leurs activités. »

Déjà, l’IA est entrée dans nos bureaux, qu’il s’agisse de Cortana, l’assistant personnel de Windows 10 ou avec des fonctionnalités comme Map, pour Excel. Et, selon un rapport d’IPsoft de janvier 2017, d’ici dix ans, les machines effectueront 80 % des tâches répétitives et chronophages et laisseront donc la place au développement de qualités typiquement humaines (pour l’instant !) : créativité, innovation, intelligence sociale et émotionnelle, résolution de conflits…

La question n’est donc plus de savoir si la révolution de l’IA aura lieu, mais comment les entreprises vont embrasser ce changement et adapter leurs workflows…