Facebook a dévoilé M2M-100, le premier modèle de traduction automatique multilingue (MMT) basé sur l’intelligence artificielle qui peut traduire un contenu dans 100 langues différentes, sans se baser sur les données de la langue anglaise. Disponible en open source, cet outil puissant permettrait « d’améliorer la qualité des traductions pour des milliards de personnes », promet Facebook.

Un modèle basé sur 15 milliards de paramètres

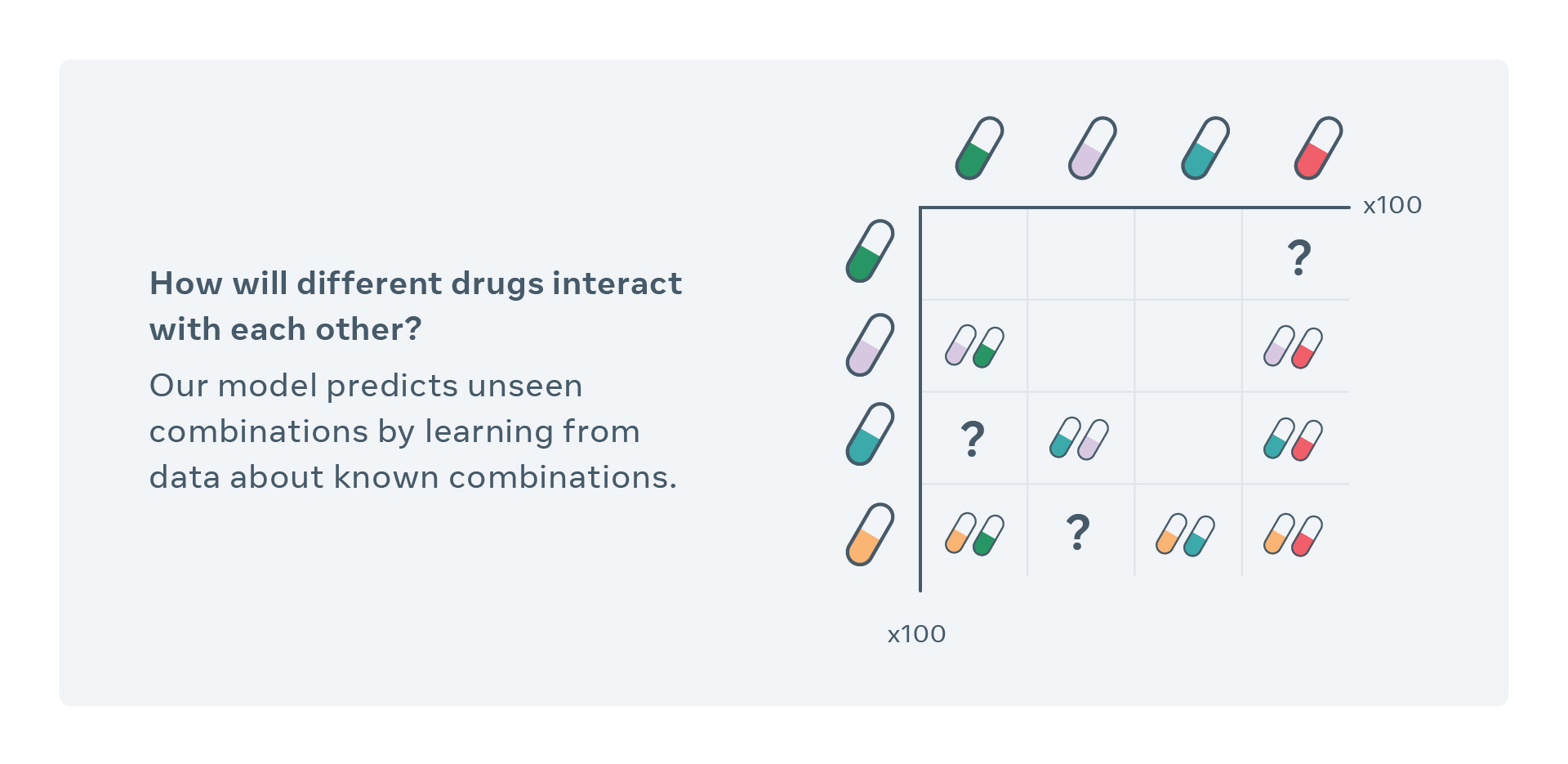

À l’heure actuelle, la plupart des modèles multilingues instantanés se basent sur les données de la langue anglaise pour effectuer leurs traductions. Pour passer du chinois au français par exemple, la majorité des outils feront d’abord un cheminement du chinois vers l’anglais, avant de passer de l’anglais au français. Un procédé qui laisse souvent place à des traductions hasardeuses.

Le département de recherche en intelligence artificielle de Facebook a travaillé à changer cela avec M2M-100, un modèle de traduction multilingue capable de traduire 100 langues entre elles, et qui passe directement d’une langue à une autre sans se baser sur l’anglais. Résultat : les traductions obtenues se montrent bien plus précises et justes que celles générées par les modèles connus jusqu’à présent.

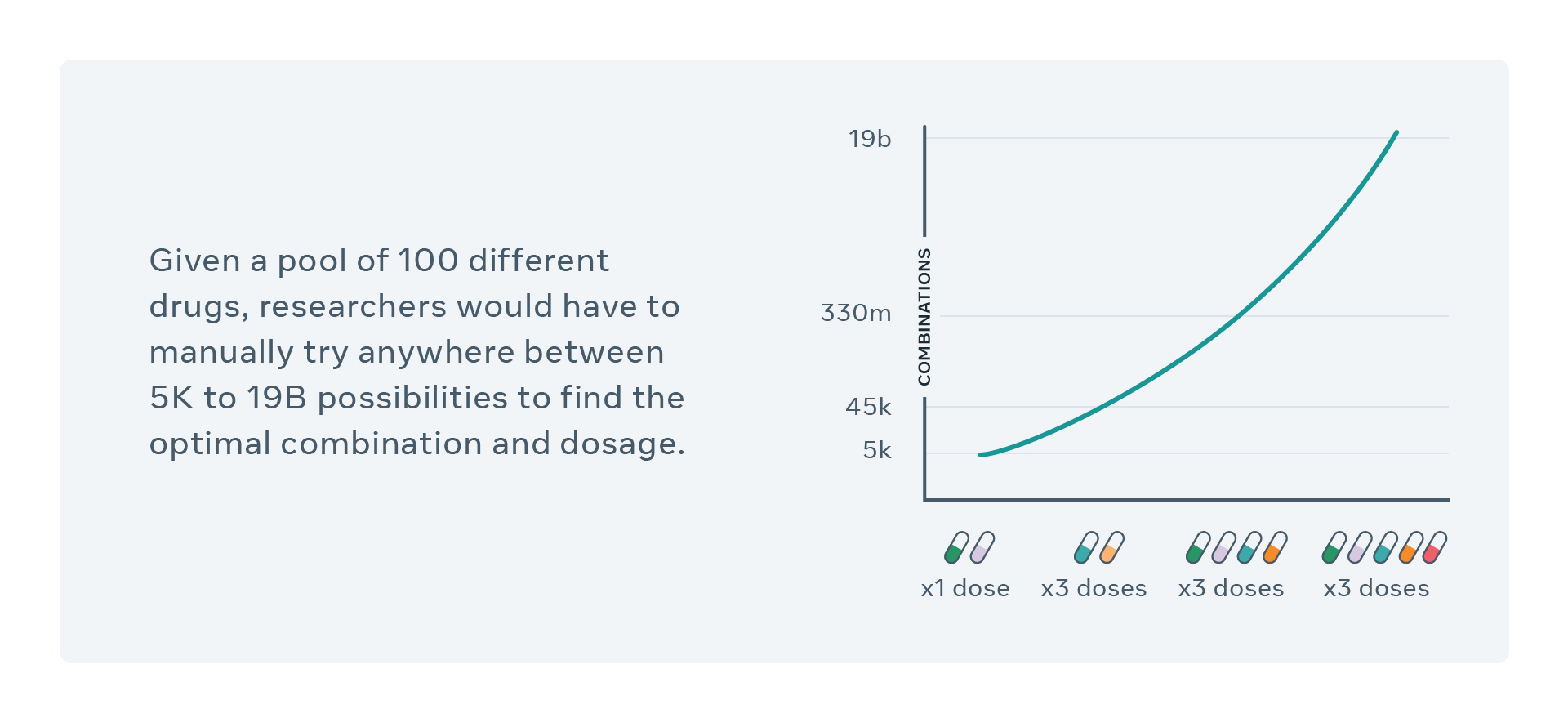

Pour parvenir à ce résultat, les scientifiques en charge du projet ont passé plusieurs années à récolter 7,5 milliards de phrases traduites dans différentes langues dans l’objectif d’entraîner leur modèle qui comporte aujourd’hui 15 milliards de paramètres. Un travail long et fastidieux qui a commencé par l’utilisation de CommonCrawl (ccAligned, ccMatrix) pour recueillir des exemples de textes sur le web. FastText, un système de classification de texte que Facebook a développé il y a quelques années, a ensuite permis d’identifier les langues dans lesquelles étaient écrits les textes.

Enfin, le protocole de minage LASER a été capable de repérer automatiquement des phrases traduites en différentes langues. Angela Fan, assistante de recherche pour ce projet, détaille : « Il (LASER) lit les phrases, prend les textes et crée une représentation mathématique de ces derniers, de sorte à ce que les phrases qui ont la même signification, correspondent à la même pensée ».

M2M-100 transcendera les traductions instantanées sur Facebook

Pour Facebook, l’utilisation de M2M-100 est toute trouvée. Grâce à ce modèle puissant, le réseau social de Mark Zuckerberg pourra considérablement améliorer la qualité des traductions instantanées disponibles sur sa plateforme, offrant ainsi une plus grande lisibilité à ses utilisateurs. Pour rappel, chaque jour, ce sont 20 milliards de traductions qui sont opérées sur Facebook. Néanmoins, avant d’en arriver là, le modèle de traduction automatique multilingue devra encore se soumettre à encore plusieurs tests de conformité.

Article source : Facebook a créé l’une des IA traductrices les plus puissantes au monde

Publié sur SiècleDigital le 20 octobre 2020 par Joana Pimenta

Document interne FaceBook :