Test

L’hydrogène isolant devient un solide métallique conducteur à très haute pression. Cette transition de phase étonnante a été observée mais elle reste mal comprise alors qu’elle pourrait révolutionner la technologie et aider à comprendre ce qui se passe au cœur des planètes géantes largement composées d’hydrogène. L’IA aide aujourd’hui à simuler sur ordinateur le comportement de l’hydrogène métallique pour percer ses secrets.

Un nouvel épisode de la saga de la quête de l’hydrogène métallique vient d’être publié avec un article dans le journal Nature par une équipe internationale de chercheurs de l’université de Cambridge, d’IBM Research et de l’EPFL. Cette fois-ci, il ne s’agit pas d’expériences à haute pression avec des enclumes de diamants mais de l’utilisation de l’intelligence artificielle via le fameux apprentissage profond avec des réseaux de neurones.

Le deep learning a permis de réduire le temps de calcul ordinairement pris sur des superordinateurs par de savantes simulations numériques, combinant les lois de la mécanique quantique et de la mécanique statistique, pour explorer les développements d’une découverte théorique faite, en 1935, par le prix Nobel de physique d’origine hongroise Eugene Wigner avec son collègue le physicien Hillard Bell Huntington. La toute jeune théorie de la liaison chimique les avait conduits à comprendre que les liaisons covalentes des atomes dans des molécules d’hydrogène H2 finissaient par laisser la place à des liaisons métalliques si l’on comprimait suffisamment ces molécules. On s’est aperçu par la suite que de l’hydrogène métallique pouvait avoir de remarquables propriétés supraconductrices, et que le cœur des planètes gazeuses géantes du Système solaire devait très probablement en contenir.

Une transition de phase problématique

Si l’hydrogène métallique est bien supraconducteur et surtout qu’il le reste à pression ambiante en étant métastable une fois produit à environ un million d’atmosphères, ses applications technologiques seraient nombreuses, facilitant les IRM et évitant des gaspillages d’énergie en conduisant le courant sur des milliers de kilomètres sans résistance, par exemple. Donc, tous les progrès dans ce domaine de recherche ne feraient pas que donner des clés pour comprendre l’origine des champs magnétiques de géantes comme Jupiter, Saturne et leurs cousines dans le domaine des exoplanètes.

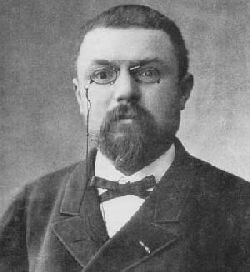

Les physiciens font savoir aujourd’hui que d’après les calculs rendus possibles par l’IA en mode Deep Learning, la transition de phase menant à l’hydrogène métallique supraconducteur ne serait pas du premier ordre dans leur jargon. Il s’agit d’une référence à des travaux initiaux du brillant physicien Paul Ehrenfest, dont la vie s’est tragiquement terminée. Au début du XXe siècle, il avait en effet esquissé une classification des transitions de phase en deux catégories. La première concernant, par exemple, le passage de la glace à l’eau liquide et la seconde le passage d’un matériau ferromagnétique de l’état aimanté à la cessation de cet état. Une classification moderne un peu différente de celle d’Ehrenfest existe et a repris ses termes, à savoir transitions du premier et du second ordre.

Un point critique caché, révélé par l’IA

« L’existence de l’hydrogène métallique a été théorisée il y a un siècle, mais ce que nous ne savons pas, c’est comment ce processus se produit, en raison des difficultés à recréer les conditions de pression extrême de l’intérieur d’une planète géante dans un laboratoire, et de l’énorme complexité de la prédiction du comportement des grands systèmes avec des atomes hydrogène », explique le principal auteur de l’article de Nature, le physicien Bingqing Cheng du laboratoire Cavendish de Cambridge.

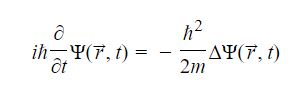

On peut se faire une idée de la difficulté théorique des calculs lorsque l’on sait que la modélisation à l’aide de l’équation de Schrödinger – l’équation fondamentale de la mécanique quantique du comportement de seulement quelques milliers d’atomes pendant quelques nanosecondes dans le cadre des conditions régnantes au cœur de Jupiter, et qu’il est difficile de reproduire en laboratoire – dépasse la capacité des supercalculateurs les plus grands et les plus rapides du monde.

Les calculs rendus possibles laissent aujourd’hui penser que la transition de phase entre l’hydrogène moléculaire et l’hydrogène atomique métallique n’est pas du premier ordre, avec une discontinuité, mais peut se faire continûment à l’aide d’un point critique caché jusqu’ici. Ce point est l’analogue du point critique bien connu en thermodynamique. Aux températures et pressions supérieures à celles du point critique pour un fluide, on ne peut plus distinguer une phase liquide d’une phase gaz, et on passe continûment des propriétés d’un liquide (à haute pression et relativement basse température) à celles d’un gaz (à relativement basse pression et haute température). On est alors en présence de ce que l’on appelle un fluide supercritique.

Un alliage métallique liquide au cœur des planètes géantes ?

Des chercheurs de l’Université de Berkeley et de l’University College de Londres viennent de publier leurs travaux au sujet de l’état de la matière à l’intérieur des planètes géantes. Selon leurs simulations sur ordinateur, les couches profondes de Jupiter et de Saturne seraient occupées par un alliage de métal liquide composé d’hydrogène et d’hélium.

Difficile de savoir ce qui se passe à l’intérieur des planètes géantes mais l’on peut tout de même en avoir quelques idées en se fondant sur les mesures réalisées en orbite par les sondes Voyager, Galileo et Cassini ainsi que par les expériences à hautes pressions qui sont réalisées en laboratoire sur Terre.

Raymond Jeanloz est un des chercheurs qui s’occupent de ce genre de problème et l’on connaissait déjà ses travaux utilisant le laser pour reproduire les conditions à l’intérieur de Jupiter. Aujourd’hui, avec son collègue Lars Stixrude, il vient de publier dans la revue Proceedings of the National Academy of Sciences le résultat de simulations de dynamique moléculaire qu’ils ont effectuées à partir de ces données et des lois de la mécanique quantique.

Contrairement à ce que l’on imaginait jusqu’à présent, l’hélium liquide métallique et l’hydrogène liquide métallique pourraient bien se mélanger pour donner un alliage conducteur ayant l’aspect du mercure au niveau du cœur de Jupiter, et même de Saturne, dans les conditions de températures et de pressions qui y règnent.

Des conditions extrêmes

Pour s’en faire une idée, rappelons que sur Terre, la graine solide, composée d’un alliage de fer et de nickel, est probablement soumise en son centre à des températures de 6.000 K, celle de la surface du Soleil, et de pressions de l’ordre de 3,5 millions d’atmosphère. Dans le cas du cœur de Jupiter, les estimations donnent des chiffres de 70 millions d’atmosphère et des températures de 10.000 à 20.000 K.

Les chercheurs avaient déjà découvert expérimentalement que l’hydrogène devenait un métal conducteur à des pressions et des températures plus basses que celles qu’ils imaginaient mais ils ne sont visiblement pas au bout de leurs surprises si l’on en croit les simulations. Il est vrai que dans ces conditions extrêmes de pression et de température les couches électroniques externes des atomes se modifient et donc, certaines des propriétés physico-chimiques que l’on était en droit d’attendre peuvent ne pas exister. Si de futures expériences avec de l’hélium le confirment bien, alors la métallisation de celui-ci doit être plus facile, et non moins, lorsque l’on s’approche de ces conditions.

Une remise en cause des sources d’énergie internes de Jupiter ?

Tout ceci a de multiples conséquences, en particulier, en modifiant notre vision du matériau liquide conducteur qui doit se trouver à l’intérieur des géantes, cela modifie aussi la façon dont leurs champs magnétique doivent être générés. S’il s’agit bien très vraisemblablement d’un effet de dynamo auto-excitatrice comme sur Terre, il faudra néanmoins tenir compte de ces nouvelles contraintes pour modéliser le phénomène. Plus révolutionnaire est le fait qu’il est maintenant plus difficile d’expliquer le fait que Jupiter rayonne plus d’énergie qu’elle ne le devrait par contraction gravitationnelle selon un processus théorisé une premier fois par Kelvin et Helmholtz au XIXième siècle.

En effet, les chercheurs faisaient jusqu’à présent intervenir la condensation de l’hélium et sa chute sous forme de pluie à travers l’hydrogène. Si leur capacité à se mélanger est bien plus élevée que ce que l’on pensait, un tel processus ne peut donc pas être invoqué comme source d’énergie gravitationnelle relâchée par la chute des gouttes. Il faudra trouver une autre explication, peut-être celle d’un réacteur nucléaire naturel même si l’idée est peu crédible.

Article source : L’IA aide à percer les secrets de l’hydrogène métallique au cœur des planètes géantes

Publié sur Futura Sciences le 08 septembre 2020 par Laurent Sacco