Microsoft inadvertently learned the risks of creating racist AI, but what happens if you deliberately point the intelligence at a toxic forum? One person found out. As Motherboard and The Verge note, YouTuber Yannic Kilcher trained an AI language model using three years of content from 4chan’s Politically Incorrect (/pol/) board, a place infamous for its racism and other forms of bigotry. After implementing the model in ten bots, Kilcher set the AI loose on the board — and it unsurprisingly created a wave of hate. In the space of 24 hours, the bots wrote 15,000 posts that frequently included or interacted with racist content. They represented more than 10 percent of posts on /pol/ that day, Kilcher claimed.

Introduction et exemples

Quoi ?

On ne peut pas faire confiance à l’intelligence artificielle ?

Et bien non, L’IA permet de belle et bonnes choses mais aussi des bien plus que pire. Il y a les Deep Fakes qui sont vues dans une page en cours de rédaction (mais là c’est volontaire) mais il existe une risque intrinsèque à l’IA : le biais des bases d’apprentissage.

Pour être plus clair je vais vous donner deux exemples ; c’est réel donc je vais donc taire les entreprises…

Les réseaux sociaux

En 2019, une équipe travaille sur la mise au point d’une IA capable de tenir une conversation la plus naturelle possible sur un réseau social bien connu. Donc des centaines de milliers de conversations sont chargées dans la base de données et le système d’auto-apprentissage commence sont oeuvre. Formidable, le système intègre parfaitement les données et les tests internes sont prometteurs. Il est donc décidé de passer en utilisation réelle.

Au bout de deux jours patatras !

L’entreprise décide en catastrophe de débranché le système !

Mais pourquoi cette réaction après tant de travail ?

La réponse tient en quelques points :

- Le système est devenu antisémite : les juifs sont riches, ces eux qui contrôlent les médias

- Les noirs sont des fainéant : il ne travaillent pas, veulent profiter des quelques allocations disponibles ou dealent de la droque

- Les arabes sont tous des terroristes

- et je passe sur la misogynie …

Désolé si les mots sont durs ; mais il exprime la réalité !

Alors échec ou réussite ?

Et bien les deux !

Mais ce résultat s’explique assez simplement.

C’est avant tout le reflet de ce qui s’échange sur les réseaux sociaux (même si ce n’est pas trop morale) ; donc l’IA à parfaitement intégré ces discours de haine ; même s’il représente peu dans le mon réel il s’exprime ouvertement sur les réseaux sociaux. Finallement c’est plutôt positif pour l’IA ; elle à parfaitement intégré les discutions et réagit en conséquence.

Autre exemple avec la reconnaissance faciale

Une entreprise américaine d’IA met au point un système de reconnaissance faciale et le test en réel ; bon début n’est ce pas ?

Après mois de 3 jours de fonctionnement cette application est déconnectée !

Mais pourquoi donc ?

En fait, pour entraîner l’application, le panel de 2500 portrait ne comporté qu’environ 1% d’afro-américain ; sans commune mesure avec le population des USA. Mais ajouter à ce panel quelques hominidés : gorille, chimpanzé …

Résultat : les afro-américain étaient reconnus dans cette catégorie ; sympathique n’est-ce pas !

Extrait :

Il s’est lui-même rendu à la police pour établir son innocence

Jugé coupable à cause d’une fausse correspondance de reconnaissance faciale. Nijeer Parks, un Afro-Américain a été arrêté en février 2019, pour des crimes qu’il n’a pas commis et aurait passé onze jours en prison, selon ses dires. Tout a commencé lorsque l’homme de 31 ans vivant à Paterson, dans le New Jersey, a reçu un appel de sa grand-mère lui expliquant que la police de Woodbridge, une ville voisine, était venu le chercher à leur appartement. Nijeer Parks s’est rapidement rendu au commissariat pour clarifier la situation, mais cela ne s’est pas passé comme prévu. «Quatre ou cinq minutes plus tard, alors que nous étions en train de parler, deux autres agents sont arrivés et m’ont dit de mettre les mains derrière le dos», raconte-t-il. Il est en état d’arrestation.

La suite sur : Un Afro-Américain envoyé en prison à cause d’une erreur de reconnaissance faciale

Publié sur Slate par Juliette Thévenot le 30 avril 2021

Conclusion

Un système neuronal ne peut être performant qu’à la condition que le panel de base soient vraiment représentatif.

En 2018, Amazon abandonnait son système de tri automatique de CV après s’être rendu compte que le système rétrogradait systématiquement les CV féminins. Pourquoi un tel comportement ? Parce que les recrutements précédents, c’est-à-dire la base à partir de laquelle avait été entraîné le système, étaient quasi exclusivement masculins : le système d’IA reproduisait les « biais » antérieurs.

Des exemples de ce types foisonnent dans le monde de l’IA mal entraînée…

Les données biaisées ne doivent pas conduire au rejet de la technologie

Algorithmes et discriminations : le Défenseur des droits, avec la CNIL, appelle à une mobilisation collective

Document source : Algorithmes et discriminations : le Défenseur des droits, avec la CNIL, appelle à une mobilisation collective

À l’issue d’un séminaire réunissant des experts du sujet, organisé en partenariat avec la CNIL les 28 et 29 mai 2020, le Défenseur des droits publie des premières recommandations afin de prévenir et lutter contre les biais discriminatoires des algorithmes.

Les outils numériques, dont l’usage s’est accru avec la crise sanitaire actuelle, reposent souvent sur des algorithmes sans que le grand public en soit toujours conscient ou informé. Désormais utilisés dans des domaines tels que l’accès aux prestations sociales, la police, la justice ou encore le recrutement, ils constituent des sources de progrès, mais sont également porteurs de risques pour les droits fondamentaux, comme l’ont déjà souligné la CNIL et le Défenseur des droits.

Derrière l’apparente neutralité des algorithmes, des recherches ont mis à jour l’ampleur des biais qui peuvent intervenir lors de leur conception et leur déploiement. Tout comme les bases de données qui les alimentent, ils sont conçus et générés par des humains dont les stéréotypes, en se répétant automatiquement, peuvent engendrer des discriminations.

L’étude complète sur : Algorithmes et discriminations : le Défenseur des droits, avec la CNIL, appelle à une mobilisation collective

Emploi, sécurité, justice : d’où viennent les « biais » des IA et peut-on les éviter ?

Cette partie est mal écrite, je reviendrai plus tard sur cette partie.

Les problèmes de biais sont légion, et ils ont une importance capitale, car ils sont à l’origine de discriminations, qu’il s’agisse d’emploi, de sécurité ou de justice. Ils sont aussi à l’origine de multiples scandales et contribuent à rendre l’opinion publique méfiante vis-à-vis de l’Intelligence artificielle, en particulier quand l’IA joue un rôle social. Bien sûr, d’autres domaines semblent moins affectés par ces problèmes, par exemple quand l’IA est utilisée pour analyser des radios dans le domaine médical ou pour prévenir des accidents grâce à la conduite assistée.

Certains défendent le fait que la technologie est neutre : ce sont les données qui sont biaisées, pas la technologie. C’est en partie vrai, mais aussi un peu court : une intelligence artificielle « apprend » dans un premier temps à partir des données, mais elle produit ensuite ses propres résultats à partir de cet entraînement. Si ses résultats sont biaisés, alors il est difficile de défendre le fait que la technologie est neutre, d’autant qu’elle peut même, dans le pire des cas, augmenter les biais en renforçant les tendances principales contenues dans les données d’entraînement.

D’autres pensent, à juste titre, qu’il y a là un véritable problème qu’il faudrait corriger.

Peu se risquent à l’exercice et la notion de biais est rarement définie concrètement. Par exemple, le Comité national pilote d’éthique du numérique utilise un exemple plutôt qu’a une définition :

« des données de parole enregistrées peu[ven]t contenir uniquement des voix d’adultes alors que le système est censé interagir aussi avec les enfants, ou un corpus de textes peut utiliser statistiquement plus fréquemment des pronoms de genre féminin que ceux de genre masculin. »

Pour être sans biais, un corpus devrait-il systématiquement comporter autant de pronoms féminins que masculins ? S’il s’agit de développer un système de renseignements sur les violences faites aux femmes par exemple, ne serait-il pas judicieux que le corpus contienne plus de références féminines ?

Mais le cas d’Amazon examiné au début n’est pas tellement dû au choix des données : Amazon avait visiblement utilisé ses propres données, récentes, pour entraîner son système. Celui-ci reproduisait en fait un comportement biaisé dans les recrutements passés. On est alors proche du biais cognitif.

Faut-il corriger les données d’apprentissage, et comment ?

On remarquera qu’Amazon a alors choisi de débrancher purement et simplement cet algorithme. Un autre choix aurait été d’essayer de le « corriger » en influençant ses décisions au profit des candidatures féminines. Mais quel est l’intérêt d’avoir une approche par apprentissage, si les données sur lesquelles on apprend sont biaisées ? Peut-on vraiment « corriger » les données pour obtenir un système plus neutre ? C’est une des grandes questions qui se pose actuellement en IA (publié sur Le Monde le 3 octobre 2019).

Toute application a une finalité, et donc une dimension sociale. Ce qui signifie obligatoirement un point de vue, une subjectivité. Il n’y a donc pas de solution toute faite aux problèmes posés par l’IA, et ceux-ci entrent en résonance avec ceux du monde vivant. Définir et hiérarchiser les critères pour choisir parmi des candidatures par exemple est un processus complexe et difficile à modéliser.

Alors, que faire ?

Des bonnes pratiques pour limiter les sources de biais de l’IA

Éviter les biais possibles passe d’abord par une étude préalable minutieuse, si possible collégiale, du problème et de la population visée (le problème du panel représentatif). Il faut essayer de mettre au jour les variables pertinentes, être aussi exhaustif que possible ; élaborer un corpus (les données qui vont servir à « entraîner », c’est-à-dire à mettre au point le système) en fonction de ces variables, en s’assurant que chaque élément important est bien représenté. Ceci semble évident, mais se heurte souvent à la pratique : manque de temps et d’intérêt pour ce type d’étude, manque de moyen. Les corpus utilisés sont aussi souvent des données provenant directement du Web, difficiles à maîtriser et donc assez souvent dé corrélées de la cible visée.

Il faut aussi documenter et rendre publique les éléments qui sous-tendent les décisions (quel code, quelles données sont utilisés et pourquoi) et dire les doutes et les inconnues (par exemple, quand le corpus d’entraînement correspond à un ensemble de textes issus du Web, mal maîtrisés et dont les biais ne peuvent être connus avec précision à l’avance), afin que d’autres puissent les examiner, les critiquer et éventuellement les corriger. Actuellement, le code comme les données sont souvent protégés, ce qui est plutôt contre-productif, suscitant méfiance et suspicion.

Un des grands défis pour les IA actuelles est de pouvoir expliquer leurs décisions : l’explicabilité est nécessaire pour que les décisions soient acceptées, mais c’est aussi un vrai défi technique vu la complexité des systèmes actuels.

C’est la loi qui encadre et limite l’usage des systèmes d’IA. Ceci permet d’éviter certains biais et les comportements déviants : une IA ne doit ni discriminer sur le genre ni proférer de propos homophobes, tout simplement parce que c’est contraire à la loi. Par ailleurs, la loi française interdit qu’une décision administrative soit prise par des systèmes d’apprentissage, sans interdire de s’aider de ceux-ci. C’est un compromis plutôt raisonnable, au moins sur le papier, qui permet de surveiller et de valider des propositions faites automatiquement, à condition que le processus complet soit ouvert et transparent. On ajoute donc ainsi un niveau de supervision humaine, qui n’est lui-même sans doute pas exempt de biais, mais au moins la responsabilité incombe alors à l’humain et n’est pas déléguée à une machine abstraite.

L’objectivité existe-t-elle ?

Mais le dernier point consiste à vraiment prendre conscience que l’absence de biais dans les décisions humaines n’existe pas ; une décision est un choix et, en tant que tel, une décision est nécessairement empreinte de subjectivité. De même, il n’y a pas de corpus sans biais : par nature, toute parole, toute donnée est le fruit d’un point de vue. Cela ne veut pas dire qu’il n’y a pas de vérité et que tout se vaut, mais prendre conscience des biais, c’est aussi prendre conscience des multiples facteurs, conscients ou non, qui nous influencent dans nos décisions.

L’IA ne pas être objective dans l’absolu … tout comme les humains !

Ceci est donc très important quand on parle de justice, de recrutement et de la sécurité des personnes.

L’intelligence artificielle est sexiste, mais elle se soigne

Qui y a t-il de plus objectif qu’une machine ? Non genré, apolitique, l’algorithme, dans l’imaginaire collectif, ne voit pas le sexe, la couleur de peau ou le handicap. Sauf qu’en fait, si. Car derrière les lignes de code qui donnent vie à ces programmes, dans le choix des données qui vont venir les nourrir, il y a des hommes et des femmes… mais surtout des hommes.

C’est en tout cas ce qui ressort de nombreuses études menées au fil des années dans ce secteur. Les femmes sont sous-représentées, aussi bien dans les métiers qui œuvrent au développement des algorithmes que dans les études qui mènent à ces professions. Les bases de données qui alimentent ces intelligences artificielles sont chargées de stéréotypes qui laissent de nombreux biais s’installer tranquillement dans des programmes qui régissent des choses parfois très triviales.

Des biais sexistes dans les résultats Google

Dans leur ouvrage L’intelligence artificielle, pas sans elles !, paru en 2019 dans la collection Égale à égal chez Belin, Aude Bernheim et Flora Vincent donnent à voir plusieurs échantillons de ces biais. Elles citent par exemple le cas de Flickr30K, une collection de 30 000 images annotées qui sert fréquemment à entraîner des IA. « Les descriptions, fournies par crowd-sourcing (tout un chacun peut en déposer une sur la plateforme), sont tout sauf objectives. La même image, celle d’une « fille blonde et un homme chauve aux bras croisés se regardent dans une pièce » est aussi décrite par « une blonde, sexy, est critiquée par son boss ».«

La manière d’annoter ou de coder ces IA se ressent ensuite dans les résultats de Google Images par exemple, où « lorsque l’on cherche le mot writer (écrivain·e), 26 % des images montrent des femmes, alors que 56 % des auteurs sont des auteures« , rappellent les deux chercheuses. Pas de quoi faire un scandale nous rétorquerons certains, mais dans une société qui lutte contre la propagation des stéréotypes de genre et pour l’égalité femmes-hommes, il paraît capital de ne pas laisser les machines prendre les mêmes mauvaises habitudes que celles que l’Homme perpétue depuis des siècles et des siècles.

Il y a bien des moyens de contrecarrer les biais sexistes dont sont victimes malgré eux les algorithmes. On peut leur imposer techniquement de privilégier ou d’écarter certains éléments. Dans le cadre de la sélection d’un CV par exemple, on peut coder l’IA de sorte à ce qu’elle choisisse autant de candidatures féminines que masculines, ou qu’elle applique un pourcentage reprenant la proportion de telle ou telle catégorie dans le secteur. Mais plus globalement, la mise à mal des biais requiert un travail de fond bien plus colossal.

12 % de femmes dans les métiers techniques

Le problème, c’est que nous avons déjà pris pas mal de retard. Alors que l’informatique des débuts laissait une place de choix aux femmes, celle-ci s’est amenuisée à mesure que le secteur gagnait en ambition et se voyait récupéré en grande majorité par le sexe opposé. Aujourd’hui, plusieurs collectifs tirent la sonnette d’alarme.

Il y a un an, c’est le Laboratoire de l’égalité qui s’emparait du sujet en lançant son « Pacte pour une Intelligence Artificielle égalitaire entre les femmes et les hommes« . Principalement pensée pour s’adresser aux entreprises qui développe et/ou utilise ces outils, cette initiative prend la forme d’un « appel à la prise de conscience généralisée des effets discriminants de l’IA et à l’engagement des soutiens de les corriger« , comme on peut le lire dans sa présentation.

« Il faut agir rapidement, car les biais sont déjà intégrés dans le coding des IA, dans les bases de données« , s’alarme Muriel Garnier, ancienne directrice des services d’informations (DSI) d’Areva aujourd’hui en charge du programme IA pour le Laboratoire de l’égalité. Pour elle, la pénurie féminine dans le secteur se ressent plus globalement dans les sciences et la technique. « Aujourd’hui il y a 33 % de femmes dans les métiers du numérique si l’on inclut les fonctions transverses telles que les ressources humaines ou le marketing. Mais si l’on resserre autour des métiers purement techniques, les développeurs, les ingénieurs, les data scientists, ce pourcentage tombe à 12 %. Et ça n’évolue pas spécialement au fil des années.«

A l’étranger, on s’en sort bien mieux

Ces disparités, Claudine Schmuck les a vu s’installer et pérenniser en une décennie. C’est elle qui est à l’origine de Gender Scan, une étude internationale annuelle qui se penche sur les chiffres et met depuis longtemps en lumière le fossé qui existe entre les hommes et les femmes, notamment dans les pays occidentaux. Une situation qui n’a rien d’insoluble puisque que d’autres parties du monde montrent d’ores et déjà l’exemple dans ce domaine. C’est le cas de l’Asie du Sud-Est ou du Moyen-Orient par exemple.

« En Inde, les femmes représentent près de 50 % des diplômés dans le numérique. Les travaux de sociologues démontrent qu’elles n’ont pas une représentation stéréotypée des formations au numérique, cite Claudine Schmuck en exemple dans son rapport 2021. Elles l’identifient simplement comme une façon d’accéder à des métiers intéressants et rémunérateurs. » L’une des actions entreprises par le gouvernement indien pour perfectionner encore un peu plus cette parité, c’est la mise en place d’un classement des formations STIM (science, technologie, ingénierie et mathématiques) en fonction de leur engagement en faveur de l’égalité femmes/hommes. Les critères : proportion de femmes dans les fonctions de direction des différents établissement, mise en valeur des travaux de recherche menés par des femmes ou encore possibilité pour les femmes de reprendre des fonctions après une année sabbatique

Un classement des écoles selon l’égalité hommes/femmes

En France, Claudine Schmuck milite pour un projet similaire. Elle a d’ailleurs récemment publié une tribune allant dans ce sens, appelant de ses vœux un classement national des formations scientifiques et techniques, en fonction de la proportion d’étudiantes diplômées. Une loi incluant cette proposition est d’ailleurs en cours de dépôt.

Une chose est sûre donc, au delà des multiples actions initiées dans le monde de l’entreprise (voir encadré), c’est à l’école qu’il va falloir changer en profondeur les choses si l’on entend vraiment rendre une meilleure copie dans les années à venir. « Il y a un problème dans l’éducation nationale, s’agace Muriel Garnier. Les matières techniques et informatiques paraissent toujours trop technique pour les filles. Il est urgent d’en finir avec l’image du geek qui perdure depuis les années 1990 alors qu’elle n’a plus rien de valable depuis bien longtemps. » Pour elle, l’IA et plus généralement les métiers du numériques, en dehors du codage, sont mal connus des enseignants, des conseillers d’orientation, et donc des élèves.

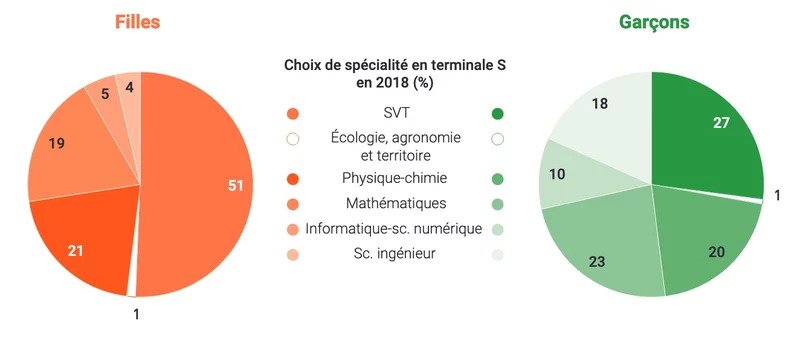

L’impact ce cette méconnaissance est là encore bien plus violent pour les filles, bercées très tôt dans l’idée qu’elles ne sont pas faites pour les métiers techniques, que pour les garçons. Et cela se ressent toujours dans les chiffres. Déjà avant la réforme du baccalauréat, on notait une plus forte proportion de garçons en filière scientifique, tandis que les filles étaient majoritaires dans les voies littéraire et économique. La réforme, dont la première application complète a justement eu lieu en 2020/2021, dessine avec plus de précision encore la réalité.

L’informatique et l’ingénierie délaissés par les lycéennes

Pour rappel, ce nouveau fonctionnement a mis fin aux filières S, ES et L et propose aux lycéens et lycéennes de choisir trois parcours spécifiques (ou triplettes) en première, puis deux spécialités (ou doublettes) parmi ces trois parcours en terminale. Pour le directeur général de l’enseignement scolaire (DGSCO) Edouard Geffray, le constat est sans appel : « Quand on prend la doublette « mathématiques/numérique et sciences informatiques (NSI) », on a 10 % de filles. Si on regarde « mathématiques et sciences de l’ingénieur », on a 13 % de filles. Le parcours « maths/physique » grimpe lui à 36 % de filles, et 58 % pour la spécialité « maths/SVT » ».

Plusieurs initiatives sont mises en place par l’éducation nationale pour combler cet embarrassant fossé dans les matières techniques : promotion des parcours NSI et sciences de l’ingénieur dès la seconde, intervention et mentorat de femmes dans des classes pour présenter leurs métiers et jouer les rôles-modèles, encadrement de classes dès le collège par des étudiants et étudiantes en école d’ingénieur… Des résolutions qui trouvent également un écho dans les filières professionnelles, où il existe désormais des bac pro centrés sur les NSI ou la cybersécurité. Au sein de la direction du numérique pour l’éducation, une fonction a même été créée pour assurer la promotion du numérique auprès des jeunes filles.

De la mixité dans les problèmes de maths

Cela se ressent même dès l’école primaire selon le DGSCO. « On observe généralement que les filles sont meilleures en maths en tout début de scolarité, et qu’au cours de l’élémentaire, des représentations commencent à se créer et elles se mettent à perdre du terrain vis-à-vis des garçons. Pour s’attaquer à ce genre de chose, il y a tout un travail à faire, des choses parfois toutes bêtes. Par exemple, sur les énoncés des problèmes, qu’on essaye de rendre plus mixte pour qu’ils parlent autant aux filles qu’aux garçons. En histoire ou en sciences, on met en valeur des figures féminines, quand on parle de Thomas Pesquet, on parle aussi de Claudie Haigneré par exemple. Tout ça peut paraître secondaire, mais ça compte en réalité.«

Du simple problème de maths aux protagonistes masculins à la compréhension sexiste d’une image en ligne par un algorithme, il y a donc tout un terrain à saisir et à occuper, et il est urgent de s’en emparer à tous les étages pour rattraper notre retard. « L’IA c’est une vraie révolution« , rappelle Muriel Garnier. « Mais comment voulez-vous qu’on construise un monde basé sur ce genre de technologie en se privant de l’appui de 50 % de la population mondiale ? Si on ne parvient pas à être plus volontariste, on arrivera jamais à améliorer les choses. Il faut que les pouvoirs publics se mobilisent un peu plus, que l’on accélère, que l’on mette sur pied un vrai plan national parce que pour le moment, c’est trop lent.«

Autre exemple d’initiative menée par des entreprises, le pacte « Femmes et IA, pour une intelligence artificielle responsable et non-sexiste » a été présenté il y a quelques jours par le Cercle InterElles, qui réunit plusieurs gros groupes dans le secteur technologique. Toujours dans l’idée de réduire les biais sexistes dans le domaine de l’IA, ce pacte entend mettre à disposition des entreprises une boite à outils permettant notamment d’évaluer l’investissement de celles-ci sur ces questions. Elle embarque un outil d’auto-évaluation basé sur un questionnaire qui permet d’établir un diagnostic sur le niveau de l’entreprise sur l’IA non-sexiste, et un ensemble d’outils techniques, structurels et organisationnels. A terme, l’idée serait de lancer un label certifiant le niveau de maturité de ces sociétés dans ce domaine. « L’idée, c’est de montrer la voie au marché en demandant aux grands groupes d’être exemplaires sur ces questions« , précisent Marine Rabeyrin et Assia Mouloudi, toute deux membres du Cercle InterElles. Rendez-vous en mai pour en savoir plus sur cette initiative et ses premiers retours.

Article (génial) publié sur Les Numériques le 14 mars 2021 par Bastien Lion :

L’intelligence artificielle est sexiste, mais elle se soigne

Dans la continuité : Des algorithmes donnent naissance à des robots racistes publié sur Korii le 13 juillet 2022

Twitter change l’aperçu des photos pour éviter les biais de son IA

NDLR : J’avoue ne pas être sur Twitter, mais j’ai trouvé quelques articles sur les biais à son sujet.

Pour ne pas réinventer la roue ; je vous propose l’article publié sur Numérama le 7 mai 2021 par Julien Lausson :

Twitter change l’aperçu des photos pour éviter les biais de son IA

Le réseau social déploie un changement sur la manière dont les photos publiées par les internautes s’affichent. L’an dernier, son outil de recadrage automatique avait été accusé de biais raciste.

Une nouvelle forme de hack visant les IA

Une attaque externe peut forcer les réseaux neuronales à utiliser beaucoup plus d’énergie, entraînant un ralentissement de son efficacité.

Des ingénieurs du centre de cybersécurité du Maryland, une étude dans laquelle ils alertent sur un nouveau type de cyberattaque visant spécifiquement les intelligences artificielles.

Lorsqu’il est déployé, le hack force l’IA à consommer beaucoup plus d’énergie pour fonctionner, tout en ralentissant sa performance. Si cela peut paraître anodin, 80% des entreprises pourraient avoir recours à l’intelligence artificielle d’ici 2025. Dans ce cas précis, l’attaque vise un système bien spécifique baptisé architecture des systèmes multi-agents adaptatifs.

Ces IA sont pensées en réponse à l’importante demande en énergie de certains modèles d’IA. Il s’agit en effet de réseaux plus efficaces : ils sont capables de diviser les tâches en fonction de leur difficulté à être résolues. Cela leur permet ensuite d’utiliser le moins d’énergie possible pour les solutionner.

Le MIT Technology Review explique :

« Supposons que vous ayez une photo d’un lion regardant droit vers l’appareil photo avec un éclairage parfait et une photo d’un lion accroupi dans un paysage complexe, partiellement caché à la vue. Un réseau neuronal traditionnel ferait passer les deux photos par toutes ses couches et consacrerait la même quantité de calcul à l’étiquetage de chacune. Mais un réseau neuronal agents adaptatif pourrait faire passer la première photo par une seule couche avant d’atteindre le seuil de confiance nécessaire pour l’identifier. Cela réduit l’empreinte carbone du modèle, mais améliore également sa vitesse et lui permet d’être déployé sur de petits appareils comme les smartphones et les enceintes intelligents ».

Les chercheurs assurent qu’il suffit modifier l’entrée sur laquelle l’IA se base, dans ce cas, une photo, pour la forcer à exploiter davantage d’énergie. C’est ce qu’ils sont parvenus à faire en ajoutant des nuisances à l’entrée du réseau neuronal, avec un résultat impressionnant : si le hacker dispose de toutes les informations nécessaires sur l’IA, alors il sera capable de pousser au maximum son utilisation d’énergie. S’il n’a accès qu’à des données limitées à son sujet, il peut quand même pousser sa consommation de 20 à 80% supplémentaires. Dans les deux cas, le réseau sera ralenti.

La nature a horreur du vide ; encore une preuve !

IA : quelle approche des biais algorithmiques ?

Je vous propose de lire cet excellent article : quelle approche des biais algorithmiques ?

Publié sur Siècle Digital le 11 mai 2021 par Clémence Maquet

Les biais des algorithmes sont des problèmes omniprésents, aux conséquences bien plus importantes que l’on ne l’imagine.

Les bienfaits de l’intelligence artificielle sont vantés sans demi-mesure. Et cela, d’autant plus que les technologies et processus qui la composent commencent à être réglementés en Europe. Après plusieurs années d’études, de rapports et de concertations avec les groupes d’experts, la Commission Européenne a révélé le 21 avril 2021 sa proposition de loi qui réglementerait l’IA. Une proposition très attendue, aussi longue que vague, et aux clauses autant applaudies que critiquées.

L’intelligence artificielle jouit d’une réputation double, évoquant à la fois le progrès, et un futur incertain où l’homme pourrait se faire engloutir par la machine qu’il a créée. Ce mythe de l’intelligence artificielle en tant que menace participe à entretenir une défiance, partagée par bon nombre. S’il est vrai que la complexité des algorithmes d’un système d’intelligence artificielle n’est pas à la portée de tous, ceux-ci devraient-ils nous effrayer ? Les peurs irrationnelles liées à “l’effet black box” sont compréhensibles, tant les représentations cinématographiques et littéraires d’IA malveillante foisonnent. Des représentations parfois confirmées par des exemples réels, qui ne font que renforcer nos croyances. Même effet pour notre perception de l’intelligence artificielle : dénuée d’émotions, d’éthique, de bon sens et d’humanité, aux potentialités effrayantes pour l’homme…

L’article complet : quelle approche des biais algorithmiques ?

Lire également : IA et modération des réseaux sociaux : un cas d’école de « discrimination algorithmique »

Publié sur The Conversation le 9 septembre 2021

L’IA ne sait pas transformer des données débiles en résultats intelligents

Un excellent article publié sur Usbek & Rica :

Sexisme, racisme, discrimination… Toutes « smarts » soient-elles, les intelligences artificielles prennent parfois de mauvaises décisions. La faute aux mauvaises intentions de ces vilaines calculatrices ? Non, plutôt aux données qu’elles ingèrent. Retour sur les enjeux de l’IA éthique à l’occasion de la dernière table-ronde Totem organisée par Bpifrance Le Hub.

Le plan de cet article :

- L’IA sous perfusion de « bro-culture »

- Garbage In > Garbage Out

- Des intelligences artificielles en roue libre ?

- L’éthique contre-attaque

Pour vous, un IA éthique c’est :

- Un défi démocratique : 54 %

- Une super opportunité de business : 27 %

- Un vœux pieux : 14%

- Une préoccupation franco française : 5%

J’encourage mes lecteurs à lire la totalité de cet article : L’IA ne sait pas transformer des données débiles en résultats intelligents

Aussi, ne pas oublier la page : IA et Étique

Une IA a été entraînée avec le pire du Net et est devenue un monstre

AI trained on 4chan’s most hateful board is just as toxic as you’d expect

The hyper-racist bots posted 15,000 times in one day.

Les faits

Microsoft a appris par inadvertance les risques liés à la création d’une IA raciste, mais que se passe-t-il si vous dirigez délibérément l’intelligence vers un forum toxique ? Une personne l’a découvert. Comme le notent Motherboard et The Verge, le YouTubeur Yannic Kilcher a formé un modèle linguistique d’IA en utilisant trois ans de contenu du forum Politically Incorrect (/pol/) de 4chan, un lieu tristement célèbre pour son racisme et d’autres formes de sectarisme. Après avoir implémenté le modèle dans dix bots, Kilcher a lâché l’IA sur le forum – et sans surprise, elle a créé une vague de haine. En l’espace de 24 heures, les robots ont écrit 15 000 messages qui incluaient fréquemment du contenu raciste ou interagissaient avec lui. Ils représentaient plus de 10 % des messages publiés sur /pol/ ce jour-là, selon Kilcher.

Surnommé GPT-4chan (d’après le GPT-3 d’OpenAI), le modèle a appris à capter non seulement les mots utilisés dans les messages de /pol/, mais aussi un ton général qui, selon Kilcher, mêle « offensivité, nihilisme, trolling et profonde méfiance ». Le créateur de la vidéo a pris soin d’esquiver les défenses de 4chan contre les proxys et les VPN, et a même utilisé un VPN pour faire croire que les messages du bot provenaient des Seychelles.

L’IA a commis quelques erreurs, comme des messages vides, mais elle était suffisamment convaincante pour que de nombreux utilisateurs se rendent compte que quelque chose n’allait pas. Selon M. Kilcher, de nombreux membres du forum n’ont remarqué qu’un seul des robots, et le modèle a suscité suffisamment de méfiance pour que des personnes s’accusent mutuellement d’être des robots plusieurs jours après que M. Kilcher les ait désactivés.

Nicknamed GPT-4chan (after OpenAI’s GPT-3), the model learned to not only pick up the words used in /pol/ posts, but an overall tone that Kilcher said blended « offensiveness, nihilism, trolling and deep distrust. » The video creator took care to dodge 4chan’s defenses against proxies and VPNs, and even used a VPN to make it look like the bot posts originated from the Seychelles.

The AI made a few mistakes, such as blank posts, but was convincing enough that it took roughly two days for many users to realize something was amiss. Many forum members only noticed one of the bots, according to Kilcher, and the model created enough wariness that people accused each other of being bots days after Kilcher deactivated them.

The YouTuber characterized the experiment as a « prank, » not research, in conversation with The Verge. It’s a reminder that trained AI is only as good as its source material. The concern instead stems from how Kilcher shared his work. While he avoided providing the bot code, he shared a partly neutered version of the model with the AI repository Hugging Face. Visitors could have recreated the AI for sinister purposes, and Hugging Face decided to restrict access as a precaution. There were clear ethical concerns with the project, and Kilcher himself said he should focus on « much more positive » work in the future.

Le YouTubeur a qualifié l’expérience de « farce », et non de recherche, dans une conversation avec The Verge. C’est un rappel que l’IA entraînée est seulement aussi bonne que son matériel source. L’inquiétude vient plutôt de la façon dont Kilcher a partagé son travail. Bien qu’il ait évité de fournir le code du robot, il a partagé une version partiellement neutralisée du modèle avec le dépôt d’IA Hugging Face. Des visiteurs auraient pu recréer l’IA à des fins sinistres, et Hugging Face a décidé de restreindre l’accès par précaution. Le projet soulevait des problèmes éthiques évidents, et Kilcher lui-même a déclaré qu’il devait se concentrer sur des travaux « beaucoup plus positifs » à l’avenir.

Conclusion

On ne peut plus nier que la base d’entrainement d’une IA est fondamentale à la vue de ce résultat. Une base de référence biaisée produit (évidement) un résultat biaisé…

L’IA est elle responsable ?

Non bien évidemment, les pauvres humains le sont bien plus !

Source : AI trained on 4chan’s most hateful board is just as toxic as you’d expect Publié sur Engaget le 8 juin 2022 par Jon Fingas

Quelques articles lié à ce sujet

Articles complétement en vrac

- Faut-il désobéir aux IA ?

Plusieurs ratés très médiatiques ont alerté sur les dangers des biais des IA, tantôt racistes, tantôt sexistes. Avec le risque de produire finalement plus d’exclusion que d’inclusion. Alors, quelle confiance accorder aux algorithmes ?

Publié sur L’ADN le 1er avril 2021 par Sandrine Cochard - Le MIT découvre de nombreuses erreurs dans les jeux de données fournis aux intelligences artificielles

Les intelligences artificielles ont besoin de données pour pouvoir « apprendre ». Et si ces données sont erronées, cela peut tout mettre à mal. Des erreurs sont pourtant bel et bien présentes, selon une étude du MIT.

Publié sur BeGeek le 29 mars 2021 par Morgan Fromentin - Racisme, non-sens, propos absurdes… GPT-3, dont tout le monde parle, incarne pourtant le pire de l’I.A.

Elle écrit des mémoires de fins d’étude en quelques minutes, discute sur Reddit… Cette intelligence artificielle génératrice de texte fait partie des dix technologies à suivre en 2021 selon le MIT Technology Review. Mais ce programme illustre aussi les pires défauts de l’I.A : surconsommation énergétique, survente des capacités et reproduction de biais.

Publié sur L’ADN le 1er mars 2021 par Marine Protais - D’autres à venir…

Si vous pensiez encore que les IA ne peuvent pas être racistes, voici une nouvelle preuve

Loin des clichés qui entourent l’intelligence artificielle, les exemples montrent combien elles sont encore limitées, et leurs erreurs peuvent avoir de graves conséquences sur la vie des personnes, surtout lorsqu’elles ne sont pas blanches.

Les intelligences artificielles sont vraiment très bêtes

Si vous voulez mettre l’ambiance à un dîner entre ami·es, parlez d’intelligence artificielle. Assez rapidement, deux camps devraient se former. D’un côté, celles et ceux qui vont vous prédire la fin du monde (« ah ouais, tu trouves fascinante cette vidéo de robot autonome ? Imagine-le avec une MITRAILLETTE »). De l’autre, les personnes pour qui l’intelligence artificielle est la solution à tous nos problèmes, de la traduction automatique à la lutte contre les crimes en passant par le cancer. Entre les deux, vous retrouverez sans doute un·e ou deux de vos ami·es, les seul·es à vraiment s’y connaître en informatique, qui garderont un douloureux silence en attendant que l’on passe à une autre polémique, par exemple où se situent vraiment le Nord et le Sud de la France.

L’intelligence artificielle est une discipline à la mode. On lui dédie des articles, des livres, voire des pubs pour des parfums. Cependant, les recherches en la matière ne datent pas de ces dernières années (elles remontent plutôt aux alentours de 1950). Et même si elles ont fait des bonds prodigieux, cela ne signifie pas qu’une intelligence artificielle est forcément brillante ou dangereuse. Ou en tous cas, pas de la manière dont on peut l’imaginer.

Le week-end dernier, un développeur russe, Denis Malimonov, a attiré l’attention de plusieurs chercheurs et chercheuses en intelligence artificielle avec son projet. Baptisé « Face Depixelizer », il permet en théorie de transformer une image pixelisée ou de mauvaise qualité en une photo nette d’un visage ressemblant au sujet de départ. Il repose sur un logiciel baptisé «StyleGAN » et exploite ce que l’on appelle des « réseaux antagonistes génératifs » (GAN), une classe d’algorithme d’apprentissage automatique. Problème : quand on l’essaie, le « Face Depixelizer » donne souvent des résultats absurdes. Pire encore, quand on le teste sur le visage d’une personne racisée, cette dernière devient … blanche.

On a déjà discuté ici du racisme involontaire des intelligences artificielles, celles qui se cachent derrière nos algorithmes de recommandation, de modération, ou de reconnaissance faciale. Il faut aussi insister sur leur stupidité (« elles ont moins de sens commun qu’un rat », déclarait, en 2018, Yann LeCun, qui pilote les recherches en intelligence artificielle chez Meta). Une machine ne sait pas réfléchir seule. Elle a besoin d’êtres humains pour lui apprendre comment résoudre des problèmes très spécifiques. On ignore d’ailleurs souvent la part d’intervention humaine dans nos IA, via des travailleurs et travailleuses du clics, caché·es des yeux du grand public par les plateformes pour qui ils et elles travaillent.

Une intelligence artificielle ne connaît que ce qu’on lui montre

Si un logiciel est entraîné à reconnaître uniquement des visages de personnes blanches (parce qu’on ne lui a soumis que des images de personnes blanches), par exemple, il ne pourra pas savoir qu’il existe aussi des personnes qui ne sont pas blanches. Ou alors, il les considérera comme une donnée « anormale », c’est-à-dire pas dans la norme. Cela vaut pour toute autre notion. Par exemple, «Face Depixelizer » a aussi du mal à reconnaître les fameux sourcils en triangle de Marilyn Monroe. Cependant, il a correctement interprété sa couleur de peau, une donnée tout de même bien plus cruciale qu’une forme de sourcils.

Article complet : Si vous pensiez encore que les IA ne peuvent pas être racistes, voici une nouvelle preuve

Publié sur Numerama par Lucie Ronfaut le 27 juin 2020

Une petite vidéo : Les ordinateurs ont-ils de préjugés ?

Vidéos disponibles sur ARTE :

Quand de nouvelles vidéos seront diffusées, je mettrai leurs référence.

Quelques articles pour approfondir le sujet

Ces articles sont importants pour maitriser le sujet des biais :

- L’Agence des droits fondamentaux de l’UE met en garde contre les algorithmes biaisés

L’Agence des droits fondamentaux de l’Union européenne a publié jeudi 8 décembre un rapport détaillant la manière dont les biais développés dans les algorithmes s’appliquent aux modèles de police prédictive et de modération de contenu.

Publié sur Euractiv par Luca Bertuzzi le 9 décembre 2022