Avant toute chose un bon algorithme est la base

Avant de commencer je souhaite partager l’article ci-dessous ; il pose bien le sujet avec de bonnes questions.

Article publié sur La Vie des Idées, c’est une critique du livre « L’assemblée des algorithmes’.

Aux confins de l’ethnographie, de l’histoire de l’informatique et de la philosophie des sciences, Florian Jaton fait la lumière sur les algorithmes, ces boîtes noires qui orientent les décisions financières, les amours et les peines.

Depuis vingt ans, les algorithmes sont présentés dans le débat public comme un pouvoir en soi. Depuis la formule « code is law » lancée en 2000 par le juriste Lawrence Lessig, de nombreux auteurs ont avancé que le traitement automatisé es données gouvernait les pratiques, se substituant au droit et à la politique. Les systèmes de recommandations construits à partir de larges bases de données orientent ainsi les décisions et les goûts sur Internet, dans le domaine des achats, de l’accès à l’information et de la consommation culturelle, présidant aux rencontres amoureuses sur les sites dédiés, à l’application des peines avec la justice prédictive, ou les investissements financiers avec les algorithmes d’aide à la décision. Les algorithmes vectorisent ainsi la société par le biais de recommandations et d’arbitrages d’autant plus puissants que leurs procédures s’avèrent en grande partie invisibles. Florian Jaton propose de faire la lumière sur ces techniques au statut de boîte noire. Pour ce faire, il emprunte un chemin aux confins de l’ethnographie, de l’histoire de l’informatique et de la philosophie des sciences. Avec l’exposition les modes de production d’un algorithme, il met en perspective l’histoire de l’informatique afin de transformer des techniques ésotériques en objets de controverses.

Pour tenir cette promesse, l’ethnographe se détourne des blockbusters algorithmiques de la Silicon Valley pour s’immerger, à la façon de B. Latour et S. Woolgar, dans la vie d’un laboratoire. L’auteur y suit une petite équipe informatique de Lausanne, spécialisée dans le domaine de l’analyse automatique de la « saillance » visuelle (p. 59), branche visant à produire des systèmes de traitement d’image sur le modèle de la vision humaine. À force de réunions, pauses café, séances de tableau noir, discussions de couloir, courriels et sessions de programmation, il en devient un membre à part entière prêtant une main mal assurée, mais suffisamment serviable pour observer en situation les étapes d’élaboration d’un algorithme.

Soutenu par des financements publics, ce laboratoire se consacre à la production de travaux académiques sur la base de liens étroits avec les grandes entreprises du numérique et l’univers des startups, au travers d’invitations à des présentations, des collaborations, des stages rémunérés, des recrutements, et le réseau de conférences qui valident et apportent la reconnaissance à plusieurs mois, parfois plusieurs années de recherche (p. 40).

Après deux ans et demi d’immersion, l’auteur le quitte avec mille pages de notes manuscrites, deux mille fichiers .txt, des douzaines de scripts codés en Python, des centaines d’images et d’enregistrements vidéo (p. 45). Il réalise à partir de cette plongée une suite d’observations, ce qui constitue un premier coup de force dans un domaine où le fonctionnement des machines et l’architecture des programmes recouvrent pour le commun des mortels le plus épais des mystères. Du temps passé à scruter des activités techniques peu spectaculaires et des tâches parfois résolument barbantes, l’auteur tire une proposition charpentée de ce qu’est un algorithme, en prenant ses distances avec ce qui en est dit habituellement.

Il est en effet courant de définir les algorithmes comme une méthode destinée à résoudre un problème à partir d’étapes suffisamment univoques, finies et systématiques pour être suivies. Dans sa somme The Art of Computer Programming, Donald Knuth avance que les algorithmes visent à transformer des données en résultats, en transformant des quantités données (« inputs ») en quantités de sorties (« outputs »). L’enquête de terrain conduit à souligner les insuffisances de cette conception. Tout d’abord, les données traitées par algorithme ne tombent pas du ciel ; ils sont le produit d’un travail d’assemblage, qui suppose le recours à des outils marqués par les désirs, croyances et contraintes propres à l’histoire de leurs conceptions. De plus, l’acceptation devenue standard de D. Knuth minimise « l’infrastructure d’évaluation des algorithmes et leurs dimensions politiques » (p. 49) : les choix et orientations ne vont pas de soi, mais sont le fruit d’une suite de décisions dont le bien-fondé pourrait prêter à discussion. Dans cette perspective, les pratiques de programmation doivent être mises sur le devant de la scène, car elles encapsulent dans les techniques une forme d’arbitraire.

Le livre est construit à la manière d’un ressaisissement de cette part d’ombre, à travers la description du processus de production. Les trois termes du sous-titre en désignent les étapes. Dans un premier temps, les chercheurs constituent une base de données cohérentes et traitables algorithmiquement. Deuxièmement, ils cherchent à rendre les jeux d’écriture suffisamment cohérents pour instruire efficacement des programmes informatiques, validés par les communautés de pairs (p. 164). Pour ce faire, ils opèrent une suite de réductions visant à transformer des entités non mathématiques (ici des images) en entités mathématisables (des valeurs, distribuées en lignes et en colonnes). Si elle est maîtrisée, cette suite d’opérations lie harmonieusement une base de données ad hoc (« ground truthing »), des activités de programmation (« programming ») reposant sur des mises en équivalence mathématiques (« formulating »). Si l’ouverture de cette boîte noire s’avère lente et délicate, c’est que l’informatique procède d’une histoire marquée par des stratégies d’occultation. Le livre impute à John Von Neumann l’acte fondateur de cette propension à l’ellipse.

En 1944, Von Neumann, l’un des scientifiques les plus influents de son temps, suit de près aux développements de l’Electronic Numerical Integrator And Computer (ENIAC), premier ordinateur entièrement électronique conçu au sein de l’université de Pennsylvanie. Pour les besoins du projet Manhattan dans lequel il est directement impliqué, le mathématicien souhaite la mise au point d’une machine supérieure en termes de puissance de calcul. L’effort de guerre rend possible l’ouverture de lignes de crédits pour financer cet ordinateur, baptisé Electronic Discrete Variable Automatic Computer (EDVAC). Sa conception met aux prises trois groupes : une équipe d’ingénieurs qui tentent de traduire des données balistiques en diagrammes électroniques par le biais d’équations différentielles ; des opératrices qui s’occupent de la traduction de ses diagrammes en signaux compréhensibles par la machine au moyen de fils électriques et de boutons de commandes ; et Von Neumann lui-même, habité par une vision de l’ordinateur relativement éloignée de l’expérience concrète et souvent chaotique des deux premiers groupes.

Attentif aux développements scientifiques les plus récents, Von Neumann trouve dans la neurologie un modèle pour l’ordinateur, qu’il envisage comme un « cerveau électronique » (p. 91). Deux chercheurs viennent de proposer une représentation simplifiée et mathématisée du cerveau humain fonctionnant comme un réseau de neurones qui communique par le biais de signaux électriques. Cette analogie se révèle décisive dans l’histoire des systèmes informatiques, souvent conçus comme des représentations schématisées et mathématisées du cerveau. Rappelant le poids des cognitivistes dans cette histoire, l’auteur dépeint l’informatique à la façon d’un arbre continu de décisions. L’orientation initiale de Von Neumann tient à son attachement pour les modèles abstraits, qui autorisent l’identification de l’esprit humain à des machines pourtant aussi « ennuyeuses que des lave-vaisselle ». Cette réduction ouvre la voie à une histoire de l’informatique reposant sur l’alignement entre entités matérielles et entités mathématiques.

En effet, le groupe étudié par F. Jaton n’a de cesse de consulter, manipuler et appareiller et comparer des valeurs. Quand les entités ne présentent pas de forme mathématique, ils travaillent à les rendre mathématisables, afin d’en faire des symboles plus facilement « partageables » et « comparables » (p. 233). Quand ils y parviennent, les frontières entre les humains et les machines sont en partie levées, puisqu’il devient possible d’adresser aux ordinateurs une liste d’instructions à suivre et répéter. Les contraintes d’espace se trouvent alors réduites : l’auteur donne l’exemple de la base de données utilisée par l’équipe, constituée par des travailleurs anonymes et à distance, payés à la microtâche sur le principe du crowdsourcing. La contrainte de temps se trouve également réduite puisque les programmes opèrent les calculs en quelques secondes là où une vie n’aurait pas suffi au seul travail humain.

L’auteur a su s’armer de références pour mener à bien ce patient et rigoureux travail d’élucidation. Car si c’est en solitaire qu’il a franchi le seuil du laboratoire, il mobilise tout au long des pages la communauté des Sciences and Technologie Studies. Les différentes générations du Centre de Sociologie de l’Innovation y figurent en bonne place, avec comme centre de gravité les travaux de B. Latour. Cette tradition de recherche, féconde, mais parfois ardue et source de malentendus, est mobilisée avec une grande clarté ce qui en fait une belle introduction in vivo. Le pari de l’auteur d’éclairer les procédures d’élaboration d’un algorithme semble donc honoré ; sur le plan scientifique tout du moins.

Car reste l’autre versant de la promesse du livre, plus directement politique. Or, si l’auteur reconstitue avec précision la manière dont un algorithme est progressivement construit localement, il ne permet pas tout à fait de saisir comment ceux d’Amazon, de Facebook, de Google ou de Netflix procèdent à une échelle internationale pour orienter les comportements.

En s’intéressant à un cas d’étude que l’on peut qualifier sans lui faire offense de périphérique, le livre rend compte presque malgré lui d’un état de fait peu mentionné dans le débat public : en majorité, les algorithmes s’avèrent bien éloignés d’une quelconque capacité d’emprise politique. Limités dans leur application, peu utilisés, ni même vraiment reconnus par les communautés d’experts, ils font l’objet d’une âpre sélection tout au long de cycles de vie parfois très éphémères, comme en fait l’expérience la petite équipe qui voit sa première proposition rejetée par une conférence de renom. La plupart sont ainsi promis à l’oubli ou à un relatif anonymat, qui en font pour l’essentiel des instruments de gouvernementalité pratiquement inopérants.

Pour les autres, que l’auteur appelle à placer au cœur du débat public, le livre ne dit finalement rien des conditions, moyens et formes d’une critique démocratique. Si Bruno Latour proposa un Sénat dédié aux problématiques environnementales et Michel Serres, un parlement du monde composé de scientifiques porteurs des causes du vivant, reste à définir ce que serait une assemblée des algorithmes : quelles modalités (électorale, représentative, délégation, cooptation, nomination, etc.), quels risques à éviter (populisme, technicisme, clientélisme, corruption, etc.), quelles procédures de mise à l’agenda ? L’auteur doit donc a minima aux lecteurs un tome 2, d’autant plus que si les textes constitutionnels ne représentent pas un sommet de littérature grand public, les codes sources ne jouent pas encore le rôle des quotidiens nationaux dans le débat public. Pour tous ceux qui s’y intéressent, F. Jaton vient de livrer un véritable roman d’apprentissage.

Texte diffusé en version française par La vie des Idées le 23 août 2021 par Olivier Alexandre

Il occupait 167 mètres carrés et pesait 27 tonnes. Rien qui ne rentre pas dans votre salon.

Vidéo de la chaine DWDocumentary

Les algorithmes des moteurs de recherche ou des services en ligne puisent dans l’immense flux de données des utilisateurs pour cerner leurs habitudes. L’informaticienne Sihem Amer-Yahia étudie cette mécanique bien huilée pour appréhender les formes de discrimination qui en découlent.

Cet entretien a été publié initialement dans le n° 11 de la revue Carnets de science.

nrdl : article plus qu’interessant !

Pourriez-vous nous rappeler ce qu’est un algorithme et le rôle qu’il joue dans le développement d’Internet ?

Sihem Amer-Yahia1. Il s’agit d’une séquence d’instructions qu’un ordinateur peut lire et interpréter dans l’objectif d’automatiser une tâche. L’algorithme peut être assimilé à une boîte qui agrège des données à partir desquelles elle produit ensuite des résultats. Ses directives peuvent être très larges. Sur le Web, cet ensemble de règles opératoires permet le plus souvent de retourner des résultats triés dans un certain ordre, comme le fait un moteur de recherche, ou de classifier des données en entrée tels les sites de e-commerce. Un algorithme peut aussi prendre des données sous une forme et les transformer sous une autre pour créer des groupes de personnes ayant les mêmes habitudes d’achats. Il est également capable d’extraire de l’information de ces données : c’est par exemple le cas des algorithmes destinés à prédire la récidive criminelle. Chaque instruction a une signification, mais c’est surtout la manière dont sont agencées ces instructions qui donne un sens à l’algorithme et détermine son utilité.

Pourquoi les algorithmes sont-ils devenus indispensables au fonctionnement des plateformes numériques ?

S. A.-Y. L’algorithme est en mesure de s’exécuter à très grande échelle et ainsi de traiter une grande masse de données rapidement et de manière complètement automatisée, ce dont l’être humain est totalement incapable.

Lorsque nous effectuons une recherche d’informations sur un moteur de recherche comme Qwant ou Google, c’est désormais un ensemble d’algorithmes qui décident de nous retourner une sélection de liens, de documents ou d’autres résultats en ligne censés correspondre le mieux à notre recherche. Pour cela, ces algorithmes se basent sur des données précalculées. Autrement dit, pour chaque mot-clé que nous entrons dans le moteur de recherche, il existe une liste de références à des sites internet qui sont pertinents pour ce mot-clé. Il s’agit en fait d’un système d’indexation des données disponibles sur le Web.

À partir du moment où un internaute entre une série de mots-clés dans Google, l’algorithme va parcourir ces références, les agréger afin de retourner des documents ou des liens qu’il aura préalablement triés par ordre de pertinence, et cela en un temps record.

Les résultats proposés par un moteur de recherche dépendent de nos précédentes requêtes sur le Web. Cela ne pose-t-il pas la question de leur objectivité ?

S. A.-Y. La grande majorité des algorithmes qui servent à aiguiller le résultat de nos recherches via un moteur de recherche ont été conçus pour personnaliser le résultat de ces recherches, et cela vaut également pour les plateformes de e-commerce et les sites de rencontre en ligne. Il est donc logique d’obtenir des résultats qui diffèrent selon le contexte dans lequel est effectuée la recherche et selon les préférences de tel ou tel individu.

Le revers de la médaille réside toutefois dans le fait que, sans forcément en avoir conscience, nous déléguons tous ces choix à l’algorithme ; or la sélection qu’il établit est loin d’être exhaustive et nous ne disposons pas d’un moyen de parcourir ou d’agréger, ni même d’avoir une idée de la diversité des informations qui sont réellement disponibles sur le Web.

En quoi consiste cette informatique sociale qui est au cœur de vos recherches ?

S. A.-Y. Notre interaction avec le Web a d’abord été celle d’un simple agent extérieur se contentant de consommer du contenu sans intervenir dans la génération de données ou dans la conception des algorithmes. Ainsi, il y a vingt ans, notre interaction avec les plateformes numériques se résumait à la recherche d’informations sur Google : nous entrions une requête qui nous renvoyait à un résultat et cela n’allait pas plus loin.

Mais depuis une quinzaine d’années, on a vu se multiplier les écosystèmes en ligne qui incitent les individus à générer des données subjectives, en donnant par exemple leur opinion. Petit à petit, nous sommes devenus partie prenante du processus de génération des données sur Internet. Au tournant des années 2010, l’individu s’est mué en employé du Web au travers d’entreprises comme Uber.

C’est toute cette évolution qui a donné lieu à l’émergence de l’informatique sociale, qui se focalise notamment sur les algorithmes à partir desquels les humains interagissent avec le contenu numérique mais aussi entre eux.

L’article complet : Algorithmes : l’injustice artificielle ?

Publié sur Le journal du CNRS le 10 janvier 2022

ndlr : je vous propose l’article suivant comme complément historique et mathématique (?) à cette partie

Le mot « algorithme » est utilisé couramment dans la presse pour désigner le fonctionnement opaque des moteurs de recherche et des réseaux sociaux.

Mais de quoi parlons-nous exactement ? Qu’est-ce qu’un algorithme ? Cette notion a traversé l’histoire, depuis Euclide jusqu’aux algorithmes des GAFAM. Les algorithmes peuvent-ils résoudre n’importe quel problème ? Quelles garanties a-t-on sur leur comportement ? Quels sont leurs impacts sociétaux ?

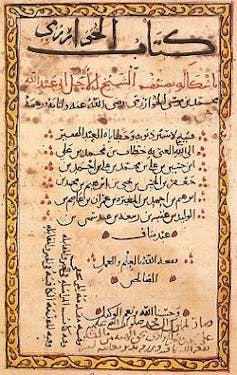

L’étymologie fait remonter l’histoire des algorithmes au savant persan Muhammad Ibn Mūsā al-Khuwārizmī, qui aux alentours de l’an 800 a publié les premiers manuels de résolution d’équations. Ses méthodes, à l’origine de l’algèbre, concernent typiquement des problèmes de calcul pratiques : des questions d’héritage ou de mesure.

Ses ouvrages sont traduits en latin au cours du XIIe siècle et popularisés par des personnalités telles que le mathématicien italien Leonardo Fibonacci. C’est son nom, latinisé en « algoritmi » ou « algorismi », qui est à l’origine du terme « algorithme ». Près d’un millénaire avant lui, Euclide avait décrit dans les Éléments une méthode pour calculer le plus grand diviseur commun de deux nombres.

Il faut pourtant attendre le début du XXe siècle pour que la notion d’algorithme soit formalisée. Dans son célèbre discours au deuxième congrès international des mathématiciens à Paris en 1900, le mathématicien allemand David Hilbert propose 23 problèmes ouverts, 23 défis à relever pour la communauté mathématique, dont les énoncés auront une influence considérable sur le développement des mathématiques dans les décennies suivantes. Le dixième problème porte sur l’existence d’une « méthode par laquelle, au moyen d’un nombre fini d’opérations, on pourra déterminer l’existence d’une solution en nombres entiers à une équation polynomiale à coefficients entiers » (les équations « Diophantiennes »). C’est bien de l’existence d’un algorithme qu’il s’agit.

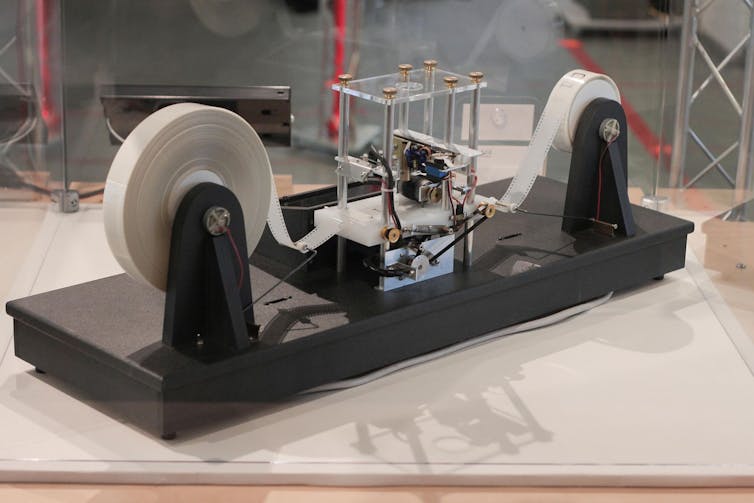

C’est par les travaux fondateurs d’Alan Turing et d’Alonzo Church, entre autres, que les algorithmes deviennent des objets mathématiques à part entière. Dans son article de 1936, Alan Turing donne sa définition de la « calculabilité » d’une fonction : il doit exister une machine qui donne sa valeur en un nombre fini d’étapes élémentaires, guidées par un système de transitions et le contenu d’un ruban, qui joue le rôle de mémoire. C’est la célèbre « machine de Turing ».

Alan Turing comprend le lien entre la calculabilité d’une fonction et le caractère démontrable d’une assertion mathématique dans un système d’axiomes. L’informatique théorique devient une branche des mathématiques.

Alan Turing comprend le lien entre la calculabilité d’une fonction et le caractère démontrable d’une assertion mathématique dans un système d’axiomes. L’informatique théorique devient une branche des mathématiques.On circonscrit la puissance des algorithmes, et certains problèmes sont démontrés indécidables : aucun algorithme n’existe pour les résoudre. En 1970, Julia Robinson et Youri Matiiassevitch résolvent finalement le dixième problème de Hilbert : la résolution des équations diophantiennes est un problème indécidable !

Au cours des années 1970, on établit des hiérarchies de problèmes en fonction du temps et de l’espace qu’un algorithme requiert pour les résoudre : c’est la théorie de la complexité.

Les algorithmes sont souvent comparés à des recettes de cuisine : une suite d’instructions précises permettant d’obtenir un résultat en un nombre fini d’étapes.

Cette image est juste, mais occulte sans doute un aspect fondamental, le fait qu’un algorithme reçoit des données à traiter (nombres, texte, relations), et certaines instructions sont conditionnelles : les étapes suivies dépendent de ces données, et les exécutions peuvent suivre un cours difficilement prévisible. On peut donner ces instructions sous différentes formes bien définies (organigramme, langage de description), ou même, avec les précautions de rigueur, en langage naturel.

Nous avons tous appris l’algorithme de multiplication de deux nombres à l’école primaire, sans l’aide d’un formalisme avancé. Les algorithmes sont en principe destinés à être mis en œuvre sous forme de programme, dans un langage de programmation compréhensible par un ordinateur. Mais l’algorithme existe indépendamment de cette traduction.

Pour mieux comprendre les enjeux et les défis actuels autour des algorithmes, il est important de cerner leur portée et les propriétés que nous sommes à même de garantir sur leurs résultats et leurs comportements. Une typologie des algorithmes est indispensable à cette compréhension.

On peut d’abord distinguer une famille d’algorithmes tellement omniprésents dans notre quotidien qu’ils y sont presque devenus invisibles. Il s’agit d’algorithmes exacts pour des tâches parfaitement bien définies, dont le résultat est facilement vérifiable : multiplier deux nombres, trier une liste de noms par ordre alphabétique, stocker et retrouver efficacement une information, effectuer la conversion d’un signal analogique vers un signal numérique, interpréter un programme.

Il s’agit là des algorithmes fondamentaux étudiés depuis les balbutiements des sciences informatiques. Ils ne font pas moins pour autant l’objet de recherches actuelles, tant des mystères subsistent autour de la complexité de certaines opérations fondamentales. La complexité exacte du problème de multiplication de deux nombres entiers, par exemple, est d’un point de vue théorique encore ouverte : nous sommes actuellement incapables de démontrer que la multiplication prend nécessairement plus de temps que l’addition ! Le meilleur algorithme de multiplication connu n’a été publié que très récemment.

Les algorithmes d’optimisation constituent une deuxième famille importante. Ils résolvent des problèmes dans lesquels on cherche à identifier des paramètres ou une configuration qui maximise ou minimise une valeur, appelée « fonction objectif ». Les applications concrètes consistent par exemple en la recherche d’un chemin le plus court entre deux points, l’ordonnancement des phases d’un projet pour en minimiser la durée, le choix des emplacements d’antennes pour couvrir à moindre coût une zone donnée, ou celui des paramètres des routeurs d’un réseau pour en minimiser la latence.

Les objectifs des algorithmes de ces deux familles sont quantifiables et leurs résultats sont mathématiquement garantis. Les méthodes formelles permettent de vérifier rigoureusement les propriétés d’un algorithme. Les algorithmes d’optimisation linéaire sont bien compris.

Une troisième famille d’algorithmes, plus spécialisés, est celle des algorithmes cryptographiques, destinés à garantir la sécurité des communications et transactions. Cette sécurité repose souvent sur des hypothèses liées à la complexité de problèmes algorithmiques. Le célèbre algorithme RSA (du nom de ses inventeurs : Ronald Rivest, Adi Shamir et Leonard Adleman), par exemple, fait reposer la sécurité des transactions commerciales électroniques sur l’hypothèse qu’il n’existe pas d’algorithme efficace pour décomposer un nombre en ses facteurs premiers.

Certaines procédures issues des recherches en intelligence artificielle, en revanche, ne se soumettent pas facilement à une analyse rigoureuse.

Parmi ceux-ci, les algorithmes de classification cherchent à placer les données reçues en entrée dans une catégorie correspondant à une réalité extérieure. Un algorithme de reconnaissance d’animaux, par exemple, recevra en entrée une image sous forme d’un tableau de pixels, et devra déterminer si cette image représente plutôt un chat ou un dauphin. Cette tâche n’est pas formellement bien définie : on peut probablement trouver une image ambiguë pour laquelle les réponses fournies par des humains pourraient être différentes. Le caractère correct de ces algorithmes dépend d’une réalité extérieure, qui n’est pas formalisée, et leur exactitude, ou précision, ne peut être établie qu’expérimentalement.

De la même manière, les algorithmes de prédiction cherchent à anticiper l’évolution de certaines quantités mesurées dans le monde physique, ou des comportements dans une population. Ils sont utilisés par exemple en finance pour prédire l’évolution des marchés, ou en marketing, pour présenter aux visiteurs d’un site web les produits ou publicités les plus susceptibles d’attirer leur attention. La pertinence des résultats est ici encore validée empiriquement, et non mathématiquement. À tel point qu’en 2006, la société Netflix a lancé un concours pour améliorer les performances de son algorithme de prédiction d’évaluations de films, avec un prix d’un million de dollars à la clé.

Le développement des ces algorithmes fait massivement appel à des modèles probabilistes, mais aussi à des structures difficilement analysables rigoureusement. C’est le cas en particulier pour les algorithmes de réseaux de neurones artificiels utilisés dans ce qu’on appelle désormais l’« apprentissage profond », en référence au nombre de couches utilisées dans ces réseaux. Ces réseaux encodent implicitement la mémoire des données fournies lors d’une phase d’apprentissage, et permettent de classifier de nouvelles données en entrée.

L’omniprésence des algorithmes fait légitimement l’objet de craintes. Quelles sont les garanties que nous pouvons exiger ?

Un premier type de garantie porte sur l’efficacité. Combien de temps doit-on attendre pour avoir une réponse ? De quelle quantité de mémoire doit-on disposer ? Ces questions sont bien étudiées et ont des formulations et des réponses rigoureuses, mais partielles. Les lacunes dans notre compréhension de la complexité algorithmique laissent en particulier ouverte la possibilité d’attaques inédites mettant en péril la cryptographie basée sur l’algorithme RSA.

La question traditionnelle des performances est intimement liée aux questions de consommation de ressources, qui ont des impacts écologiques. On peut donner à cette question un cadre plus large, et s’interroger sur les ressources consommées par les logiciels, les serveurs. Dans le domaine des algorithmes cryptographiques, certains mécanismes au cœur du fonctionnement des cryptomonnaies, en particulier le principe de la « preuve de travail », ont un impact énergétique dramatique.

Lorsque les objectifs sont facilement vérifiables, comme dans le cas d’un algorithme de tri, ou quantifiés explicitement, comme dans le cas d’un algorithme d’optimisation, il existe une mesure objective de la qualité de la solution. Dans le cas des algorithmes d’optimisation, cependant, le choix de la fonction objectif, la quantité que l’on optimise, peut avoir un impact humain considérable.

Les questions d’équité et de transparence des algorithmes de classification et de prédiction deviennent pressantes. Dans un ouvrage devenu classique, Cathy O’Neil alerte sur les dérives des systèmes de prise de décision dans les domaines de la justice, de l’action policière, des assurances, de l’évaluation des enseignants, entre autres.

L’algorithme de Gale-Shapley, utilisé par la plate-forme Parcoursup satisfait des propriétés d’optimalité, mais garantit également qu’un comportement stratégique de la part des postulants est impossible.

Les méthodes d’apprentissage supervisé pour la classification consistent classiquement en une collection d’exemples, de paires « entrée-sortie », dont on espère qu’ils peuvent être généralisés, de façon qu’une nouvelle donnée en entrée puisse être associée à une réponse en sortie qui fasse sens. En ne fournissant que des exemples connus lors de ces phases d’apprentissage, on inculque au système tous les biais présents de facto dans les exemples dont on dispose, et l’on apprend ainsi à la machine à les reproduire. C’est le thème du documentaire Coded Bias, relatant l’expérience d’une étudiante du MIT avec les algorithmes de reconnaissance faciale.

Le caractère parfois inexplicable des résultats termine d’expliquer le glissement sémantique récent du mot algorithme : de simple méthode de calcul, l’algorithme est perçu comme une boîte noire omnipotente, dont le fonctionnement interne est inaccessible, et dont les réponses finissent par se substituer à la réalité. Cette perception s’explique notamment par la résurgence des méthodes de réseaux de neurones, dont la complexité défie toute analyse formelle. Les succès expérimentaux dans les tâches confiées aux réseaux profonds sont indéniables et fascinants. Mais certaines expériences mettent en évidence leur fragilité : des chercheurs ont montré qu’en modifiant de manière imperceptible quelques pixels bien choisis d’une image, on peut changer du tout au tout la réponse fournie. En l’absence d’explicitation de la réponse (« c’est un chat, car il a des oreilles pointues et des moustaches »), les questions de confiance et de responsabilités se posent.

La communauté de recherche en intelligence artificielle et en apprentissage automatique s’est emparée des questions d’équité et d’explicabilité : le développement de méthodes d’apprentissage incluant des critères d’équité (fairness in AI) est en plein essor, tandis que le domaine de l’intelligence artificielle « explicable » (explainable AI) traite de la justification des résultats et de la confiance.

Al-Khuwārizmī aurait sûrement été surpris de la postérité de son patronyme !

Article source : Qu’est-ce qu’un algorithme ?

Publié sur The Conversation par Jean Cardinal le 9 décembre 2021