Pour la première fois depuis le début du test de référence MLPerf sur l’entraînement de l’IA en 2018, Nvidia n’avait pratiquement aucune concurrence à ses puces dominantes.

Introduction

Le géant des puces Nvidia projetait déjà une longue ombre sur le monde de l’intelligence artificielle. Et pourtant, sa capacité à évincer la concurrence du marché pourrait s’accroître, si l’on en croit les derniers résultats des tests de référence.

Le MLCommons, le consortium industriel qui supervise un test populaire des performances du machine learning, MLPerf, a publié mercredi les derniers chiffres concernant la « formation » des réseaux neuronaux artificiels. En trois ans, Nvidia a eu un seul concurrent : le géant des processeurs Intel.

Lors des tours précédents, y compris le plus récent, en juin, Nvidia avait deux concurrents ou plus. Parmi eux, Intel bien sûr, mais aussi Google, avec sa puce « Tensor Processing Unit » (ou TPU), ainsi que la start-up britannique Graphcore. Par le passé, le géant chinois des télécommunications Huawei lui faisait également concurrence.

Nvidia rafle les meilleurs scores

Par manque de concurrence, Nvidia a cette fois-ci raflé tous les meilleurs scores alors qu’en juin, la société avait partagé la première place avec Google.

Nvidia a présenté des systèmes utilisant son GPU A100, sorti depuis plusieurs années, ainsi que son tout nouveau H100, connu sous le nom de GPU « Hopper » – en l’honneur de la pionnière de l’informatique Grace Hopper. Le H100 a obtenu le meilleur score dans l’un des huit tests de référence, pour les systèmes dits de recommandation couramment utilisés pour suggérer des produits sur le web.

Intel a proposé deux systèmes utilisant ses puces Habana Gaudi2, ainsi que des systèmes étiquetés « preview » qui présentaient sa prochaine puce Xeon sever, dont le nom de code est « Sapphire Rapids ». Les systèmes Intel se sont révélés beaucoup plus lents que ceux de Nvidia.

Des records mondiaux

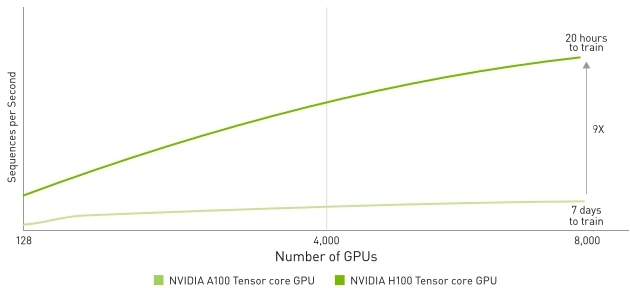

« Les GPU H100 (aka Hopper) ont établi des records mondiaux en entraînant des modèles dans les huit charges de travail d’entreprise MLPerf. Ils ont fourni jusqu’à 6,7 fois plus de performances que les GPU de la génération précédente lorsqu’ils ont été soumis pour la première fois à l’entraînement MLPerf. Par la même comparaison, les GPU A100 d’aujourd’hui sont 2,5 fois plus puissants, grâce aux progrès des logiciels », souligne Nvidia dans un communiqué de presse.

Dave Salvator, chef de produit senior pour l’IA et le cloud de Nvidia, a insisté lors d’une conférence de presse sur les améliorations des performances de Hopper et les modifications logicielles apportées à l’A100, montrant à la fois comment Hopper accélère les performances par rapport à l’A100 – un test de Nvidia contre Nvidia, en d’autres termes – et comment elle est capable de piétiner en même temps les puces Intel Gaudi2 et les Rapids Sapphire.

L’article complet : IA : Dans le dernier test de performance, Nvidia évince la concurrence

Publié sur ZDNet par Tiernan Ray le 14 novembre 2022