Quel est l’apport de l’intelligence artificielles dans les sciences ?

Le 8 octobre 2024, le prix prestigieux prix a été décerné à l’Américain John Hopfield et au Britanno-Canadien « pour leurs découvertes sur l’apprentissage automatique avec des réseaux de neurones artificiels. »

Geoffrey Hinton est connu pour être l’un des pères fondateurs de l’IA (intelligence artificielle). En 2023, dans un article du New York Times, il mettait en garde contre les « profonds risques pour la société et l’humanité » liés à cette technologie.

John Hopfield, âgé de 91 ans en 2024, est professeur à la prestigieuse université de Princeton.

Cette distinction signe la reconnaissance de l’Intelligence Artificielle par le monde des sciences et permet de faire mieux connaitre ces deux chercheurs.

Depuis Galilée, la recherche en physique suivait une procédure bien balisée, structurée par trois préceptes : observation des phénomènes naturels, conceptualisation d’une loi les sous-tendant, vérification des prédictions qui en découlent.

Cette démarche a porté de multiples fruits et nous connaissons aujourd’hui en détail les lois qui s’appliquent au monde entre l’échelle des particules élémentaires et celle de l’univers global. La méthode qui s’est magistralement développée pendant les quatre derniers siècles s’appuie sur la loi de causalité et suit la démarche réductionniste de Descartes : devant un problème, il faut le décomposer en autant d’étapes permettant de construire des suites simples de raisonnement. À chaque étape, le déterminisme s’applique. Si l’on ne trouve pas d’enchaînement causal, c’est parce qu’on n’a pas réduit suffisamment le problème. Cette démarche s’accorde avec le principe de parcimonie d’Ockham, selon lequel il faut choisir l’explication la plus simple pour comprendre la nature, la complexité n’étant qu’une solution de dernier recours.

Aujourd’hui, ce paradigme semble rejeté par les techniques à la mode du machine learning (ML), qu’on traduit par apprentissage automatique et qui est une sous-catégorie de l’intelligence artificielle dont on parle à tout propos.

Est-ce une révolution et si oui, qu’en déduire ?

L’intelligence artificielle se donne pour but de réaliser une machine capable d’imiter l’intelligence humaine. Elle est utilisée pour la traduction automatique de textes, l’identification d’images, en particulier la reconnaissance faciale, la publicité ciblée… L’objectif du machine learning est plus spécifique. Il vise à enseigner un ordinateur à exécuter une tâche et à fournir des résultats en identifiant des correspondances dans un lot de données. Le ML écrit des algorithmes qui découvrent des motifs récurrents, des similarités dans des ensembles de données existantes qu’on va ensuite exploiter pour interpréter une nouvelle donnée. Ces données peuvent être des chiffres, des mots, des images… Les programmes informatiques du ML sont capables de prédire des résultats sans tenter d’analyser les détails des processus mis en jeu. Le réductionnisme de Descartes est clairement oublié.

La technique des réseaux de neurones est l’un des outils de la méthode. Il s’agit d’algorithmes se présentant sous forme d’un réseau à plusieurs couches. La première permet l’ingestion des données à analyser sous forme d’un lot de paramètres (image d’un chien par exemple), une ou plusieurs couches cachées tirent des conclusions à partir des données dites « d’entraînement » antérieurement accumulées (images de milliers de chiens), et la dernière assigne une probabilité à l’image de départ. Comme le nom l’indique, les réseaux de neurones s’inspirent directement du fonctionnement du cerveau humain. Ils analysent la complexité en tenant compte de toutes les corrélations existantes, comme peut le faire la vision globale de l’œil.

En décelant des régularités dans un grand jeu de données stockées, les algorithmes améliorent leurs performances au fil du temps dans l’exécution d’une tâche. Une fois entraîné, l’algorithme pourra retrouver les motifs dans de nouvelles données à partir de ceux dont on l’a nourri. Mais pour obtenir un résultat satisfaisant, il faut entraîner le système avec un jeu d’apprentissage aussi étendu que possible qui reste représentatif et non biaisé, et cela explique le problème de fond de la méthode : le résultat dépend de l’entraînement. Ainsi, un processus distinguera plus facilement les chiens que les loups s’il a été soumis à plus d’images de chiens pendant l’apprentissage. Un cas récent classa un chien comme loup parce qu’il apparaissait sur un fond blanc. Les images d’entraînement montraient souvent des loups sur fond de campagne enneigée.

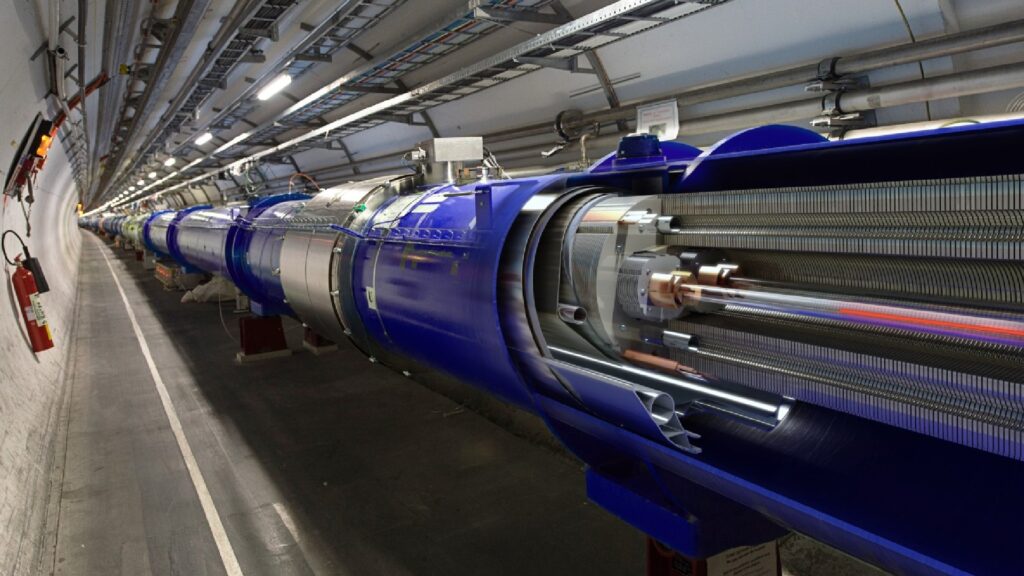

En recherche fondamentale aussi, la nouvelle technique est massivement utilisée pour l’analyse de données complexes. Elle permet de développer, de tester et d’appliquer des algorithmes sur différents types de données afin de qualifier un événement. Par exemple, le ML aide les physiciens à gérer les milliards d’interactions entre protons obtenues au grand collisionneur du CERN découvreur du boson de Higgs. Les réseaux de neurones peuvent rendre le filtrage de données plus rapide et plus précis. La technique s’améliore de manière autonome au fil du temps.

Ceci constitue une rupture avec les méthodes passées où on cherchait d’abord à identifier tel ou tel type de particules parmi les produits de la réaction en appliquant des règles de sélection adaptées pour ensuite examiner l’interaction dans sa globalité.

Ici, on exploite directement la structure d’ensemble d’un événement. Ainsi, pour la recherche de nouvelles particules, un modèle théorique fixe une phénoménologie avec ses paramètres associés. Les physiciens simulent la création et la détection de ces particules. Ils simulent aussi le « bruit » causé par toutes les autres réactions prédites par le Modèle standard, à charge pour le machine learning de distinguer le signal recherché et la réponse est donnée sur une échelle de probabilité de vraisemblance.

Pourtant, la science ne peut s’appuyer aveuglément sur le ML. Les physiciens qui exploitent cette révolution doivent rester aux commandes. Pour l’heure, un humain est encore nécessaire pour examiner de manière critique ce que délivrent les analyses algorithmiques. Son rôle est de donner du sens aux résultats, et de s’assurer que les données traitées ne sont ni biaisées ni altérées. De même, un physicien voulant utiliser un traducteur automatique de l’anglais au français doit s’assurer que le mot wave est bien rendu par onde et non par vague dans l’expression de la dualité onde-corpuscule.

La physique classique se voulait déterministe, elle donnait un résultat unique à un problème donné. La méthode du ML, de par sa construction, répondra de manière probabiliste avec une possibilité d’erreur qu’on cherchera à minimiser. En gagnant en efficacité et en rapidité d’analyse, on abandonne la certitude pour se contenter de vraisemblance. On peut d’ailleurs souvent s’en satisfaire, la vie elle-même étant probabiliste.

En son temps, Einstein s’était opposé à l’indéterminisme inhérent à la mécanique quantique. Il pensait que le cerveau humain était capable d’expliquer complètement la réalité. En cela, il suivait un préjugé fort respectable venant de la philosophie grecque. De fait, la mécanique quantique introduit un hasard intrinsèque qui viole les a priori des physiciens. Mais ce hasard reste contraint, il maintient un déterminisme collectif puisqu’on sait exactement prédire l’évolution d’une population de particules. Devant les nouveaux développements, il faut admettre que le probabilisme devient une propriété obligatoire inscrite dans la technique de recherche elle-même. Einstein devrait se retourner dans sa tombe.

La physique classique tentait de rationaliser la démarche de connaissance en conceptualisant une loi dont on vérifiait expérimentalement les conséquences. Avec le ML, on cherche toujours à prédire l’évolution d’un phénomène, mais la phase de conceptualisation a disparu. On puise dans la richesse des grands nombres pour définir un patron qu’on appliquera au problème posé. La construction d’une théorie ne semble plus nécessaire pour résoudre un problème. Les notions d’objectif et de subjectif se mélangent.

On disait que la physique explique le « comment » des phénomènes naturels, à charge pour d’autres esprits d’en expliquer le « pourquoi ». Ici, il faut revoir la notion d’explication, la part de l’intelligence pure dépensée s’efface, ou du moins, devant les prouesses de l’ordinateur, l’intelligence humaine ne sert plus qu’à améliorer le processus informatique. L’homme se met au service de la machine.

La physique a-t-elle perdu ses repères ? J’avais perdu les miens et devant mon désarroi, un théoricien me tança :

« Tu crois donc que des gravitons s’échangent entre le Soleil et la Terre pour maintenir notre planète sur son orbite ? Les particules virtuelles n’existent pas, ce sont de simples artifices de calcul. »

Et je compris alors que le ML devait être accepté comme un artifice de calcul plus élaboré que ceux du passé, mais cela ne me semblait pas sans conséquence.

La physique ne cherche plus à expliquer, elle se satisfait d’un résultat pertinent à un problème obtenu avec le maximum d’efficacité. Or, ce qu’on n’explique pas, il faut l’admettre. Pascal avait déjà senti une limitation de principe dans la physique ; il classait l’espace et le temps parmi des grandeurs primitives dont il faut accepter la réalité sans explication, parce que c’est « comme ça ». Platon avec son allégorie de la caverne avait eu l’intuition que nous ne ferons toujours qu’interpréter des ombres, sur le fond d’une mémoire d’ordinateur dans le cas du ML. Et tout cela rappelle l’injonction de Saint-Augustin qui écrivit, dans un contexte évidemment très différent : « Il faut croire pour comprendre. » Alors que conclure ? En 1989, on annonçait « la fin de l’histoire ». La prophétie s’avéra très exagérée, espérons que les développements informatiques ne signent pas « la fin de la physique ».